前言:人工智能领域的研究始于1956年达特茅斯学院的一次研讨会。自此,人类开始了探索这一智能形态的漫漫长路。人工智能行业在相当长的一段时间里都处于起起伏伏的周期中,每当有新的原理突破而引发新的技术诞生,人工智能就会再次走进大众的炽热期待中,因为每一次突破都可能意味着人类与人工智能的“终极形态”又近了一步。2017年,当今大模型的底座Transformer架构横空出世;几年后,获得了智能涌现的ChatGPT展现了强大的通用能力。我们不禁好奇,大模型作为人工智能领域的最新代言,究竟能够怎样赋能各行各业,并开拓哪些新的人工智能主导领域;大模型从哪里来,未来又到哪里去?为探究这些问题,我们从大模型背后的技术原理出发,在宏观认知上把握生成式人工智能的“前世今生”;接着,我们深入产业链的纵横延伸,探索背后的一系列运行逻辑;最后,我们从行业全景现状中跳脱出来,既仰望星空,又脚踏实地,启发理性思考,以飨读者。生成式人工智能让人们看到,通往强人工智能的道路不再那么遥远。人类与人工智能共舞的那一天,或许正在可预见的时空范围内慢慢接近我们。

一、AGI相关概念简述

(一)AGI与ANI

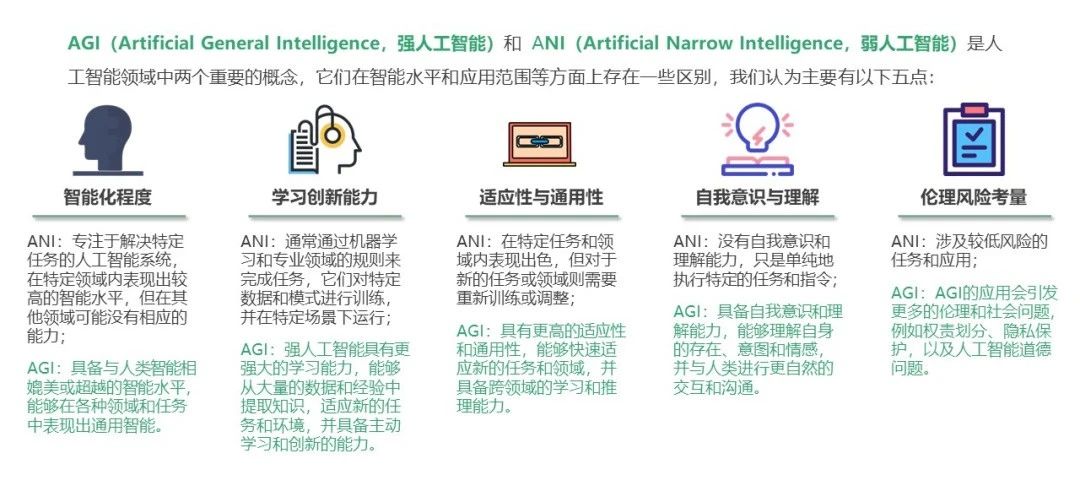

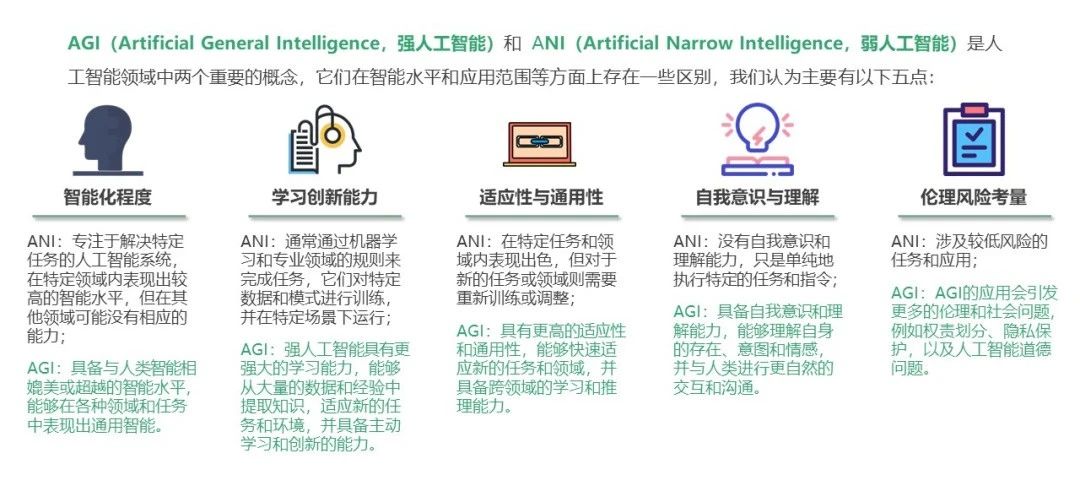

AGI(Artificial General Intelligence,强人工智能或通用人工智能)的研究目标是寻求统一的理论框架来解释各种智能现象,并研发具有高效的学习和泛化能力、能够根据所处的复杂动态环境自主产生并完成任务的通用人工智能体,使其具备自主的感知、认知、决策、学习、执行和社会协作等能力,且符合人类情感、伦理与道德观念。相比之下,ANI(Artificial Narrow Intelligence,弱人工智能)通常只能够解决一个特定问题,缺乏一般认知能力。ANI在智能化程度、学习创新能力、适应性和通用性、自我意识与理解、伦理风险考量几个方面与AGI存在差距。AGI是人工智能领域的一项愿景,目前尚未实现,处于研究和探索的阶段。对于AGI的具体特点与实现路径,仍然存在各种不同的观点和研究方向。

图1 AGI与ANI对比

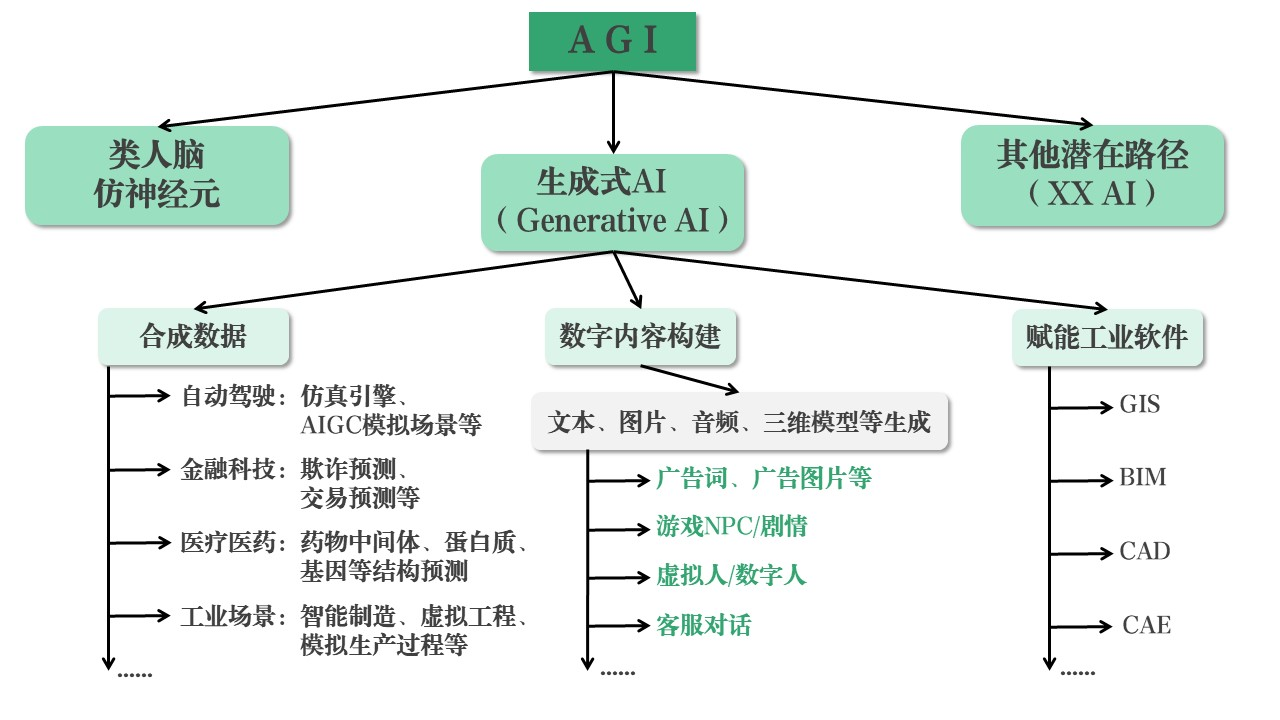

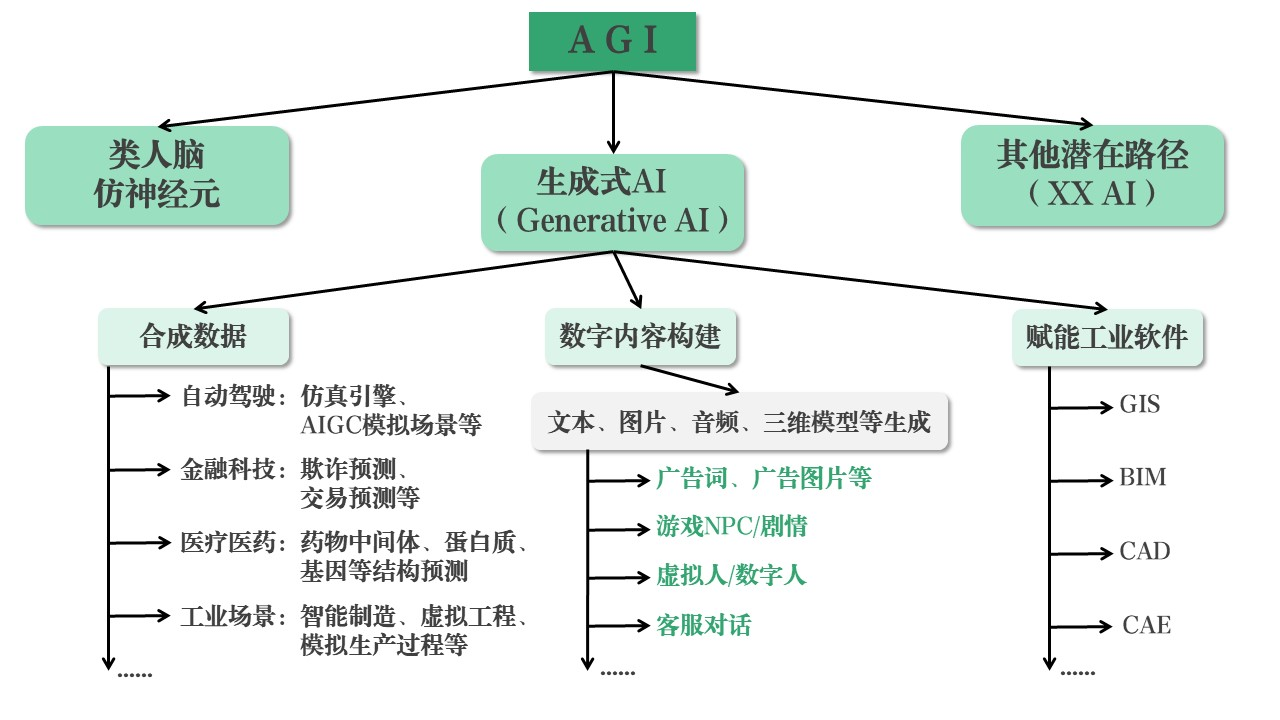

(二)通往AGI的原理路径

图2 AGI-Generative AI-应用在许多条有希望通往AGI的技术原理路径中,生成式人工智能(Generative AI;又称Artificial Intelligence Generated Content,AIGC)是近几年被广泛提起,并且受到热门关注的一项技术。它能够学习输入训练数据的模式和结构,生成具有相似特征的文本、图像或其他内容。生成式人工智能的爆发得益于GAN、CLIP、Transformer、Diffusion、预训练模型、多模态技术、生成算法等多项人工智能技术的突破、累积与不断融合。不断迭代创新的算法和基于Transformer架构的预训练模型引发了生成式人工智能的能力质变,多模态技术进一步推动其能力向多边形拓展。生成式人工智能正逐步拥有更强大和更通用的基础能力,因此其被视为目前通往AGI的一条最有希望和可实现的技术原理路径。

(三)宏观认知

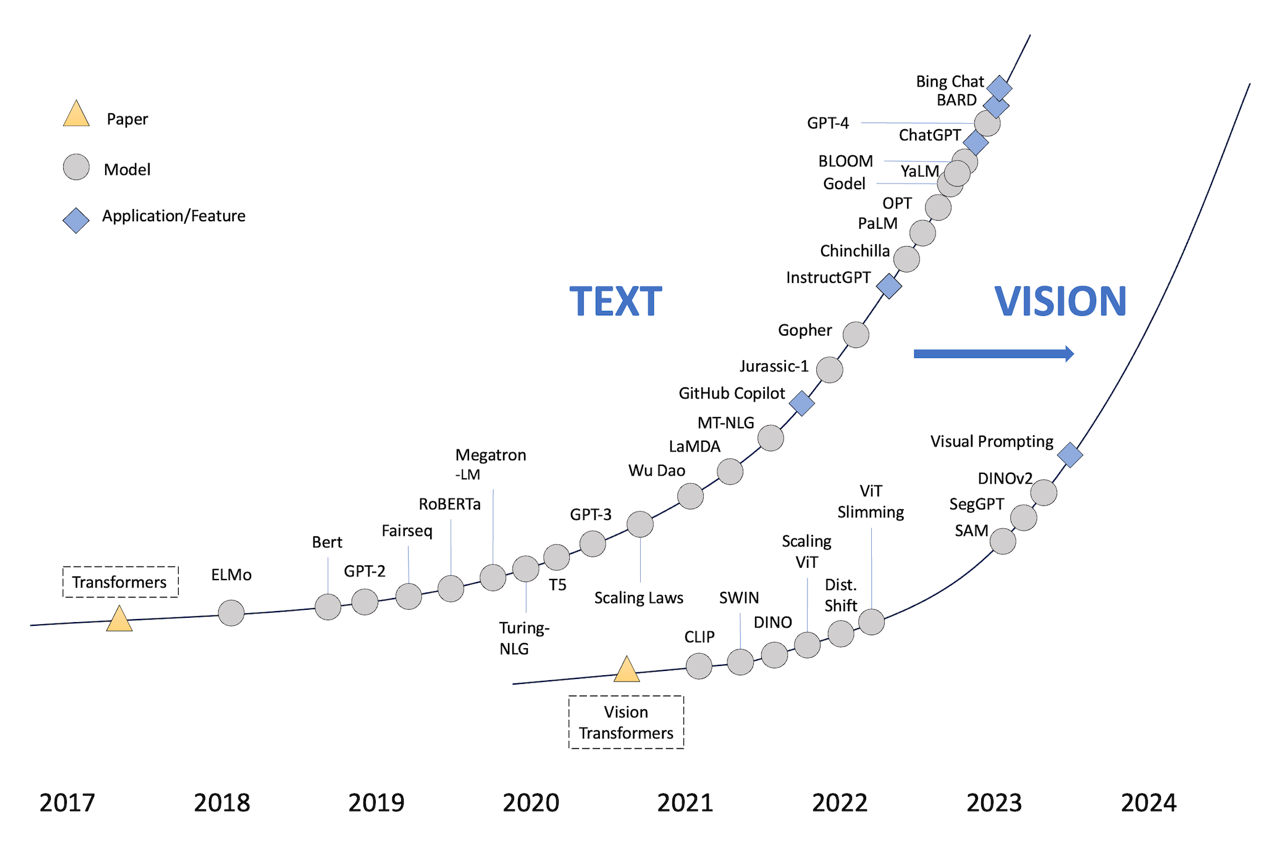

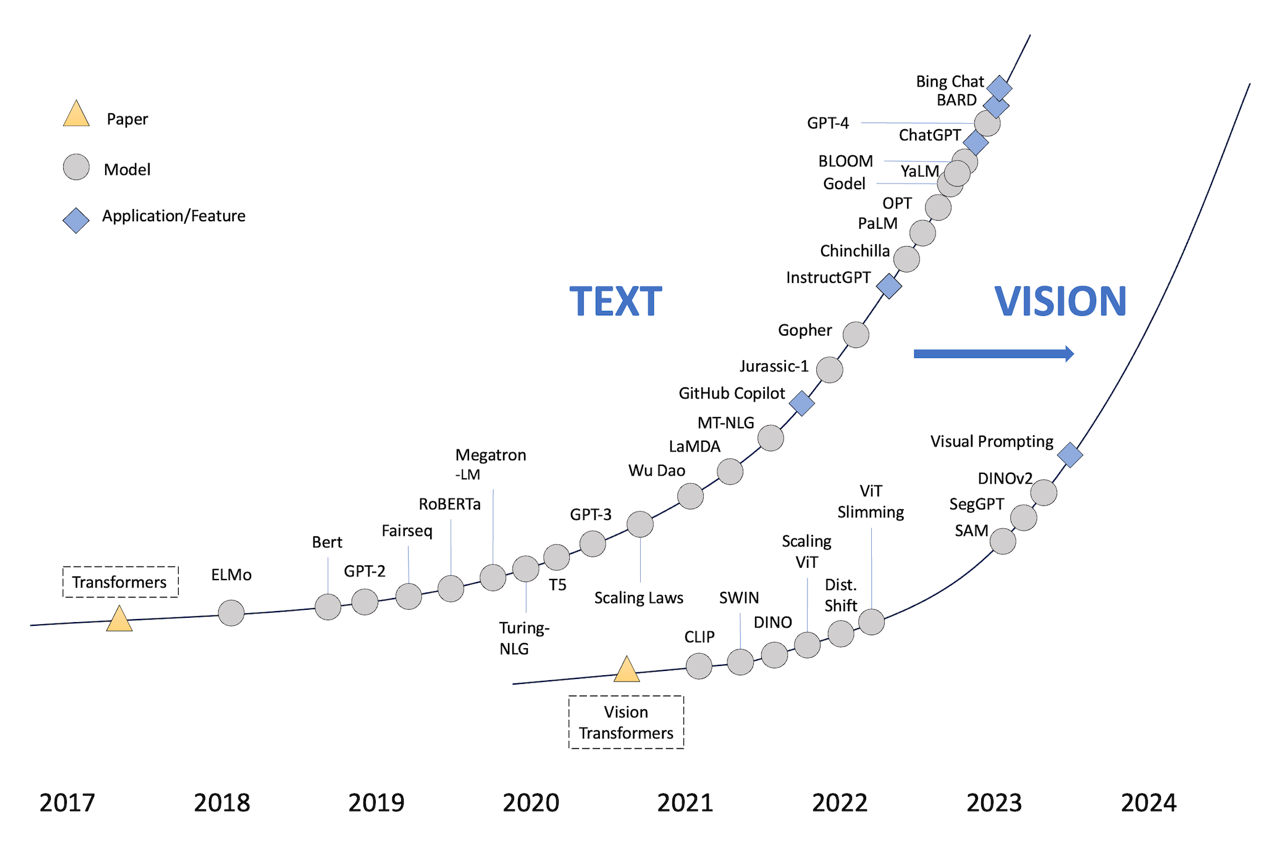

1.Generative AI发展节点图

我们梳理近年来大模型领域一些具有里程碑意义的论文或研究文献,形成如下关于生成式人工智能发展节点图。节点图在时间尺度上展现了生成式人工智能在文本(Text)和视觉(Vision)领域的学术发展历程,具体表现为各个语言或视觉模型的创新和迭代。下面对图中部分节点代表的模型进行简要介绍,为读者铺展开大模型的“前世今生”,生动展现技术不断突破和迭代融合的磅礴画卷。

图3 Generative AI学术发展节点图

(团队整理,Credit to Prof. Andrew Ng from HAI of Stanford University)

(1)TEXT(文本)

2017年,谷歌公司发布Transformers架构,这一技术突破使经过该架构预训练出的模型在NLP(Natural Language Processing,自然语言处理)领域表现十分突出,是生成式人工智能在文本领域发展的基石性节点架构。

1)ELMo

ELMo(Embedding from Language Models)的核心思想是深度上下文(Deep Contextualized),除提供临时词嵌入外,还提供生成这些词嵌入的预训练模型。在实际应用中,ELMo可以基于预训练模型,根据实际上下文场景动态调整单词的词嵌入表示。

2)BERT

BERT(Bidirectional Encoder Representation from Transformers)是Transformers的双向编码表示,是谷歌提出的一个面向自然语言处理任务的无监督预训练语言模型,也是近年来自然语言处理领域公认的里程碑模型。

3)GPT-2

GPT-2是一个15亿参数量的自回归(Auto-regression)语言模型,在基于大量高质量数据预训练的过程中,模型已经学习到各种任务的相关信息,能够在不进行模型微调的情况下仍然可以较好地处理文本翻译、摘要提取、文本分类等下游任务。

图4 GPT-2的自回归特性[1]

4)Fairseq

Fairseq是一个全新卷积神经网络(CNN)的语言翻译模型,由脸书公司AI实验室在2017年提出。和以往以RNN为基础的翻译模型相比,Fairseq输出结果能以9倍相比于以往循环神经网络的速度实现更高的准确率。

5)RoBERTa

RoBERTa(A Robustly Optimized BERT)是强力优化的BERT方法。相比BERT有更大的模型参数量、更多的训练数据,以及更先进的训练方法,使得RoBERTa具有更强的语言表现,能够比BERT更好地推广到下游任务。

6)Megatron-LM

Megatron-LM是由英伟达公司的应用深度学习研究团队开发的大型语言模型,对BERT的模型架构进行了改进。与BERT相比,该模型在一系列自然语言处理任务中获得了更高的分数。

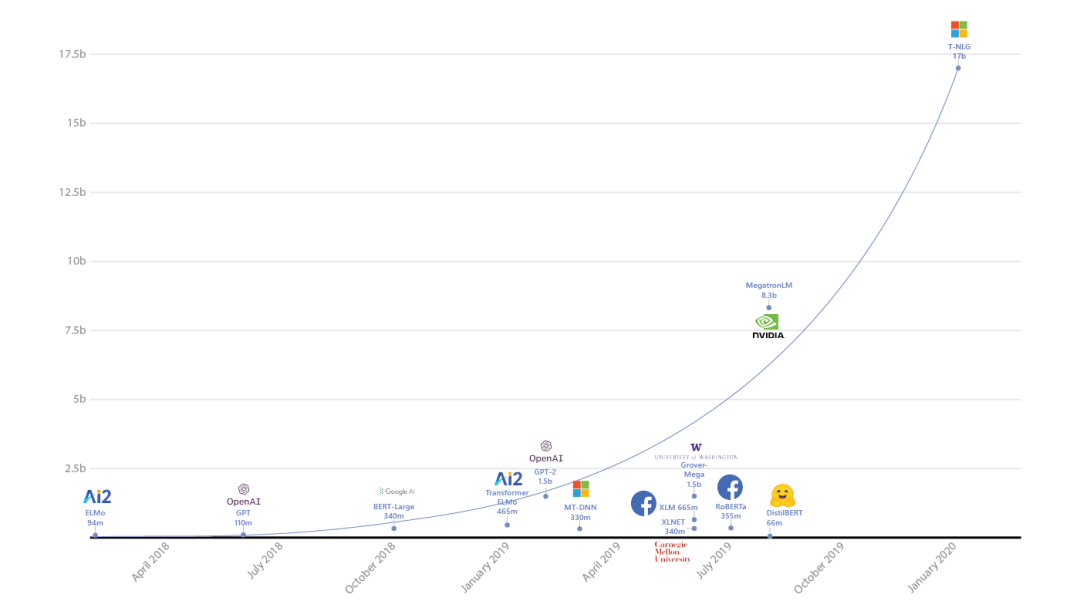

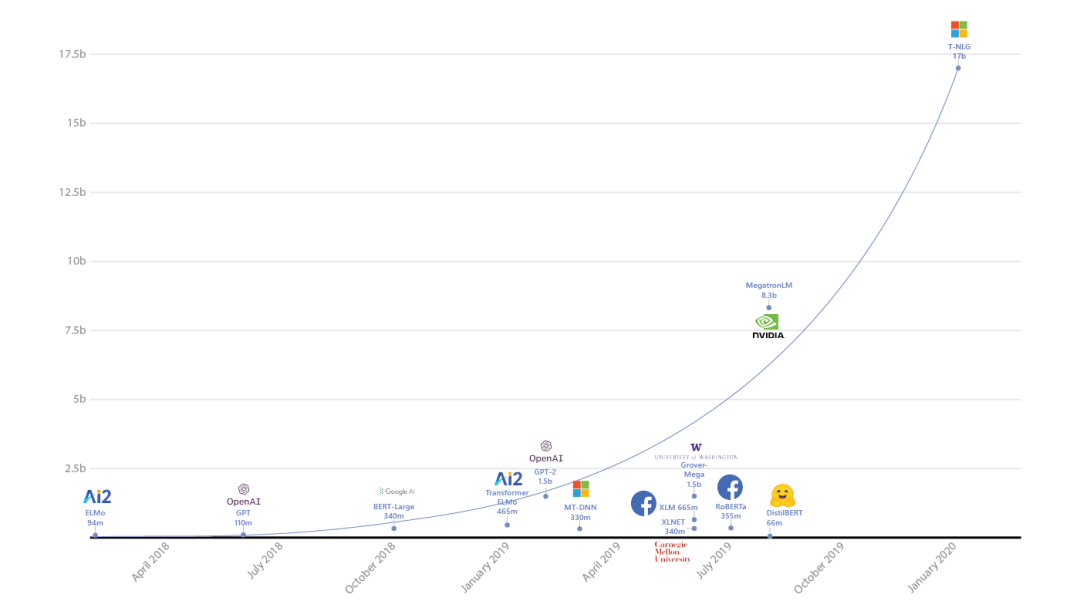

7)Turing-NLG

Turing-NLG是微软发布的大型语言模型,得益于当时软硬件的突破,其拥有170亿参数量,是Megatron-LM模型参数的两倍,拥有直接生成问答或在零样本下生成问答,以及以更少的监督生成抽象式摘要的能力。

图5 Turing-NLG实现当时语言模型的最先进水准[2]

8)T5

T5(Transfer Text-to-Text Transformer)是谷歌公司提出的“文本到文本”生成模型,能够将不同形式的任务统一转化为条件式生成任务,只需一个统一的模型就可以使用同样的训练方法与解码过程完成不同的自然语言处理任务,而无须针对不同任务设计不同的模型结构与训练方法。同时,这种“大一统”模型还能够极大地降低不同任务之间迁移学习与多任务学习的难度。例如,在语言翻译的情景下,假设需要翻译“That is good”,将“translate English to German:That is good.”输入模型,就可以直接输出德语翻译 “Das ist gut.”。

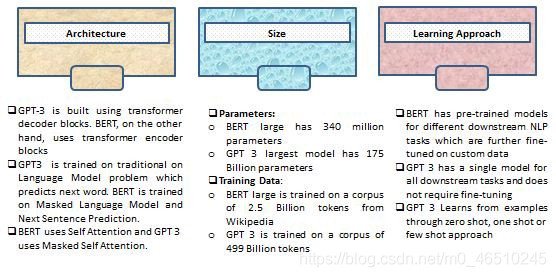

9)GPT-3

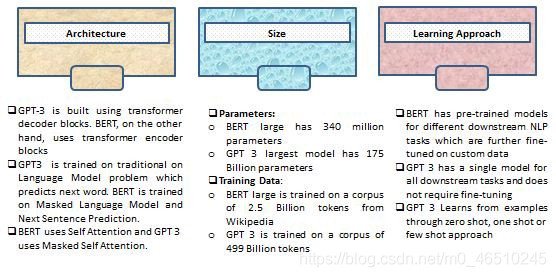

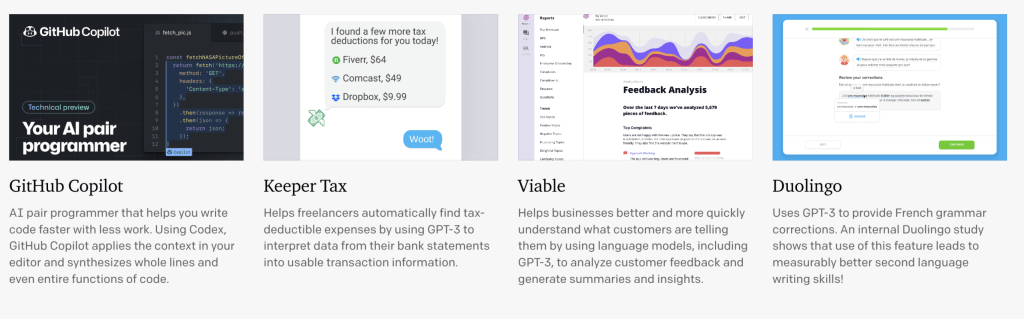

图6 GPT3与BERT对比[3]GPT-3是由OpenAI公司开发的1750亿参数量大型语言模型。它不仅能够生成流畅自然的文本,还能够完成问答、翻译、创作小说等一系列自然语言处理任务,甚至能进行简单的算术运算,性能在很多任务上都超越相关领域的专有模型。GPT-3是首个可以通过API访问的大型语言模型,创新了MaaS(Model as a Service,模型即服务)的服务模式。

10)Wu Dao

悟道(Wu Dao)是由北京人工智能研究院开发的多模态生成式模型。悟道2.0拥有1.75万亿参数量,使用专家混合(MoE)模型,除自然语言处理任务外,还能够基于语言描述生成近乎真实的图像,或基于图像生成替代文本。

11)LaMDA

LaMDA(Language Models for Dialog Applications)是由谷歌公司发布的1370亿参数量对话式大语言模型,其拥有接近人类水平的对话质量,以及检索利用外部知识源的能力,使得模型在“安全性”和“事实性”方面具有显著改进。

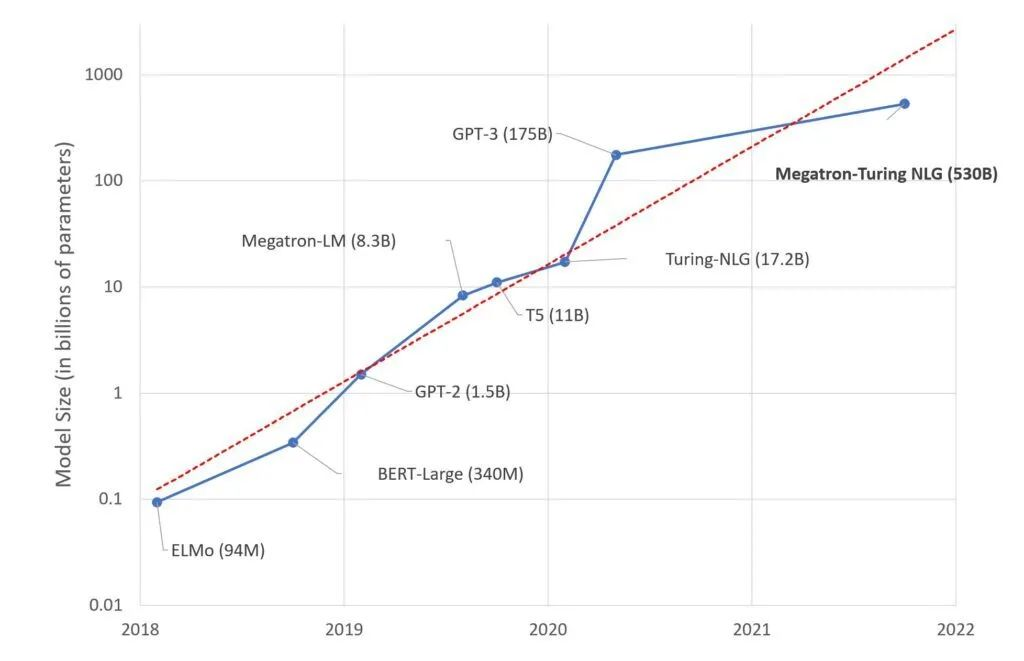

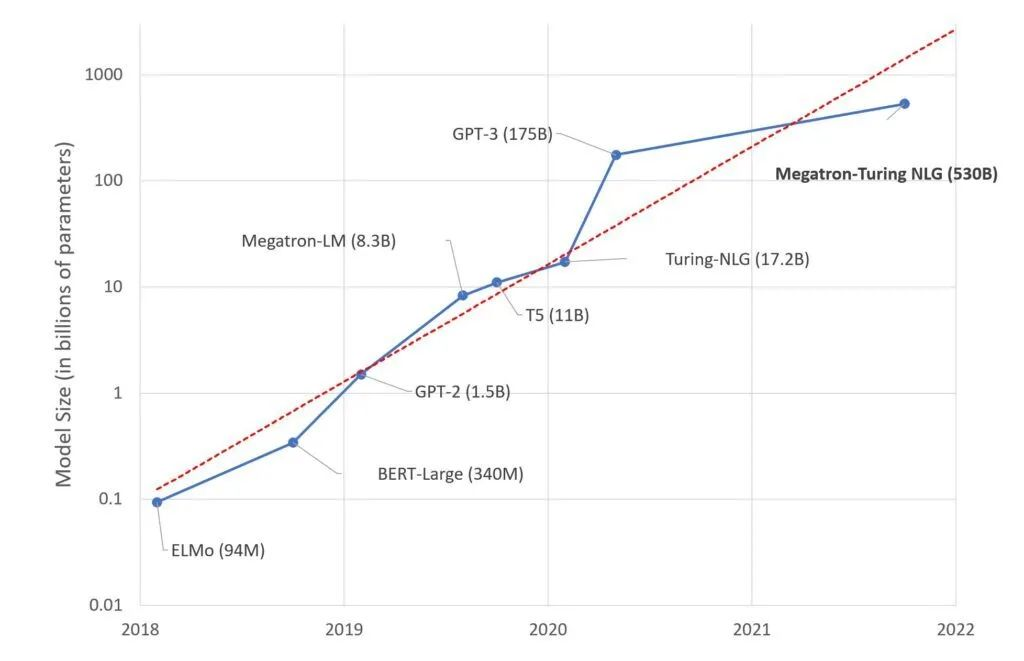

12)MT-NLG

MT-NLG(Megatron-Turing NLG)是微软和英伟达公司联合发布的5300亿参数量大语言模型,是Turing-NLG和Megatron-LM模型的继承者;得益于大规模计算、大型数据集,以及模型训练算法的快速发展。NLP模型的参数量保持指数级增长趋势,其在一系列自然语言任务中也实现了更强的性能。

图7 NLP模型参数量规模趋势[4]

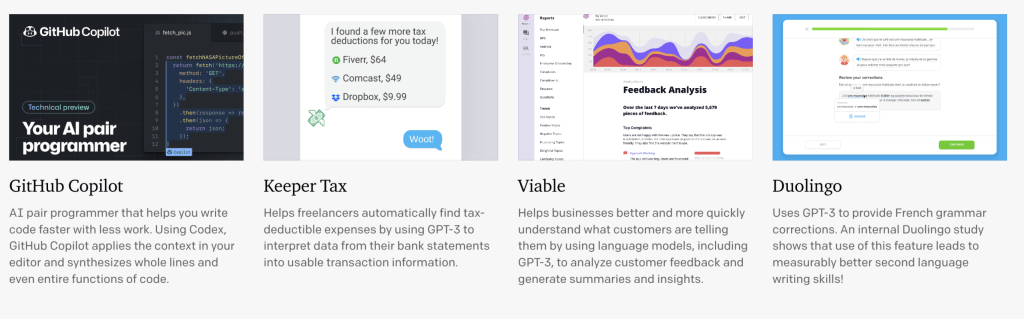

GitHub Copilot是由GitHub和OpenAI开发的基于GPT-3的代码生成工具,能够生成代码片段,为程序员提供代码建议以及其他辅助功能。

14)Jurassic-1

Jurassic-1是AI21 Labs发布的一个1780亿参数量自回归语言模型,作为第一个使用包含多词汇(multi-word)token的语言模型,Jurassic-1相比GPT-3能够使用更少的token来表示同一个语句,提高了模型效率,且在语料库测试中表现优于GPT-3。

15)Gopher

Gopher是DeepMind公司发布的2800亿参数量大语言模型[5],其以自回归Transformer架构为基础进行了适当的结构调整,在巨量训练参数下实现了接近人类的阅读理解能力。相比GPT-3、Jurassic-1和Megatron-Turing NLG等大语言模型,其在知识密集型任务上改善大,在推理性任务上改善较少。

16)InstructGPT

InstructGPT是GPT-3的微调版本,其在人类编写的指令数据集上进行了训练,使得InstructGPT相比GPT-3能够更好地理解输入的语言,生成更准确和更相关的输出。

17)Chinchilla

Chinchilla是由DeepMind公司开发的大型语言模型[6],是对Gopher模型的进一步发展。其优化了数据训练效率,可以使用更少的算力来进行推理和微调,改善了计算资源有限的大型自回归语言模型开发情况,从而使用更大、更高质量的训练数据集以取得更好的模型性能。

18)PaLM

PaLM是谷歌公司发布的5400亿参数规模大语言模型[7],能够执行包括:常识推理、算术推理、文本解释、代码生成和翻译等任务。与思维链提示相结合时,在需要多个步骤推理的数据集上取得了显著的性能提升。

19)OPT

OPT是Meta公司发布的开源大型语言模型,可以完整访问模型权重进行调试和学术研究,其中OPT1750亿参数量模型和GPT-3的性能相当,但通过模型优化只需要消耗部署GPT-3七分之一的算力。

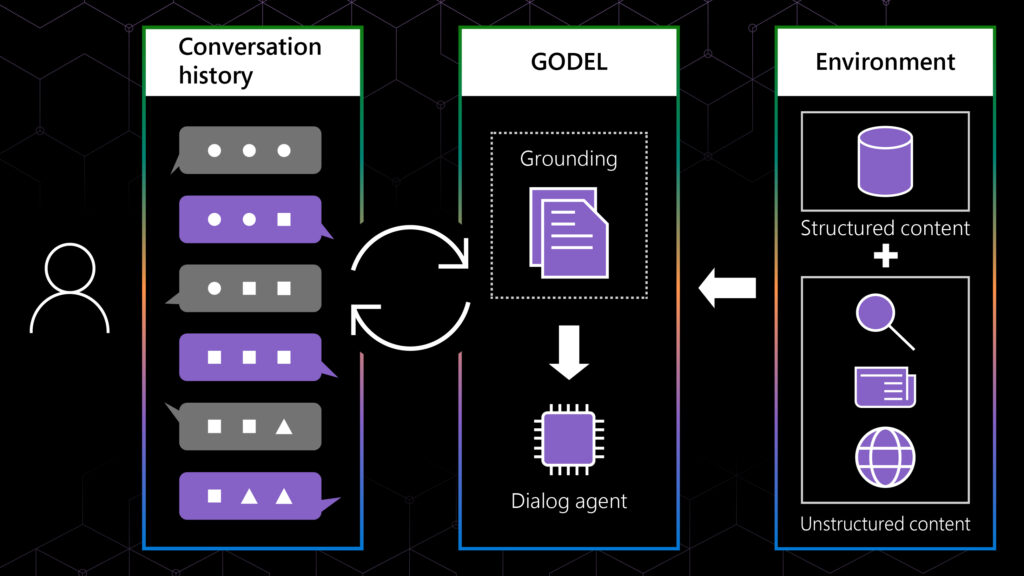

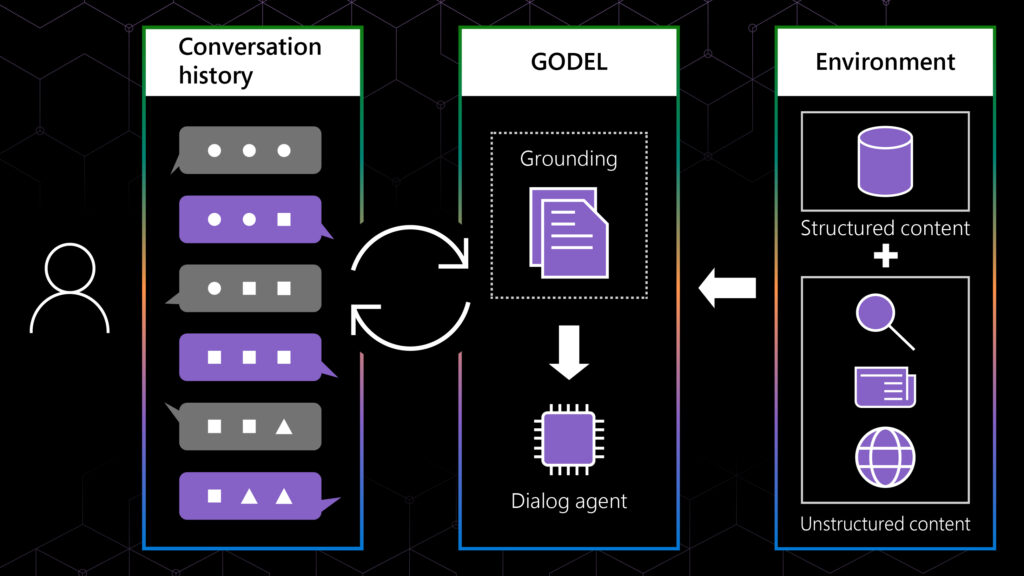

20)GODEL

GODEL是微软公司发布的对话语言模型[8],其结合了任务导向和开放式聊天,不仅能够根据对话上下文生成响应,还能够根据外部信息(模型训练时不属于数据集的内容)生成响应。

图8 GODEL运行原理示意[8]

21)YaLM

YaLM是由Yandex发布的一个1000亿参数规模语言模型[9],是同时期最大的开源可商用生成式语言模型,目前GitHub上已有3.6k stars。

22)BLOOM

BLOOM是由HuggingFace发布的1760亿参数量开源大型语言模型,BLOOM在各种基准测试中都取得有竞争力的表现,旨在通过开源来促进LLM的研究和应用。

23)ChatGPT、GPT-4、Bard、Bing Chat

2022年,OpenAI公司发布ChatGPT,其利用Transformer架构进行预训练和微调,使得计算机能够生成与人类语言相似的文本,再结合正反馈人工训练机制,使ChatGPT在生成摘要、文档和充当聊天机器人等方面具有突出表现。ChatGPT上线两个月活跃用户破亿,远远超越了大众对于一款对话聊天机器人的预期。在此之后的升级版GPT-4以及其他科技巨头跟进发布的基于语言大模型的人工智能产品,我们会在后面的篇幅详细介绍。

(2)VISION(视觉)

在计算机视觉(Computer Vsion,CV)大模型出现之前,计算机视觉领域的图像分割任务通常使用传统的图像处理和机器学习方法来解决。这些方法主要包括以下两种:

- 基于边缘检测的分割方法:该方法基于边缘检测技术来提取图像中的边缘信息,并利用分割算法将边缘连接成为完整的区域。这种方法依赖于图像中的局部特征,如纹理、灰度等,容易受到噪声、光照等因素影响;

- 基于区域生长的分割方法:该方法从图像中选取一个或多个起始种子点,在此基础上通过一定规则不断扩展相邻区域,最终完成整幅图像的分割。这种方法可以利用区域间的全局信息,但对于起始种子点的选择和规则的设计需要人工经验和调试。

这两种传统方法都非常耗费人力和时间,需要由领域内的专家进行高度专业化的工作,并且不能提供通用的全自动分割方法。

1)CLIP

CLIP(Contrastive Language–Image Pre-training)是一种基于对比文本-图像对的预训练方法[11],主要包含Text Encoder和Image Encoder两个模块,分别提取文本和图像特征,然后基于比对学习,让模型学习到文本-图像的匹配关系。CLIP方法的核心就是利用自然语言的监督信号来训练一个视觉模型。CLIP打破了之前固定种类标签的范式。无论是在收集数据集还是训练模型过程中,可以直接搜集图片和文本的配对来预测相似性,大大提高视觉模型收集数据、训练、推理的效率,在零样本条件下也可以进行各种各样的分类任务,具有很强的泛化能力。

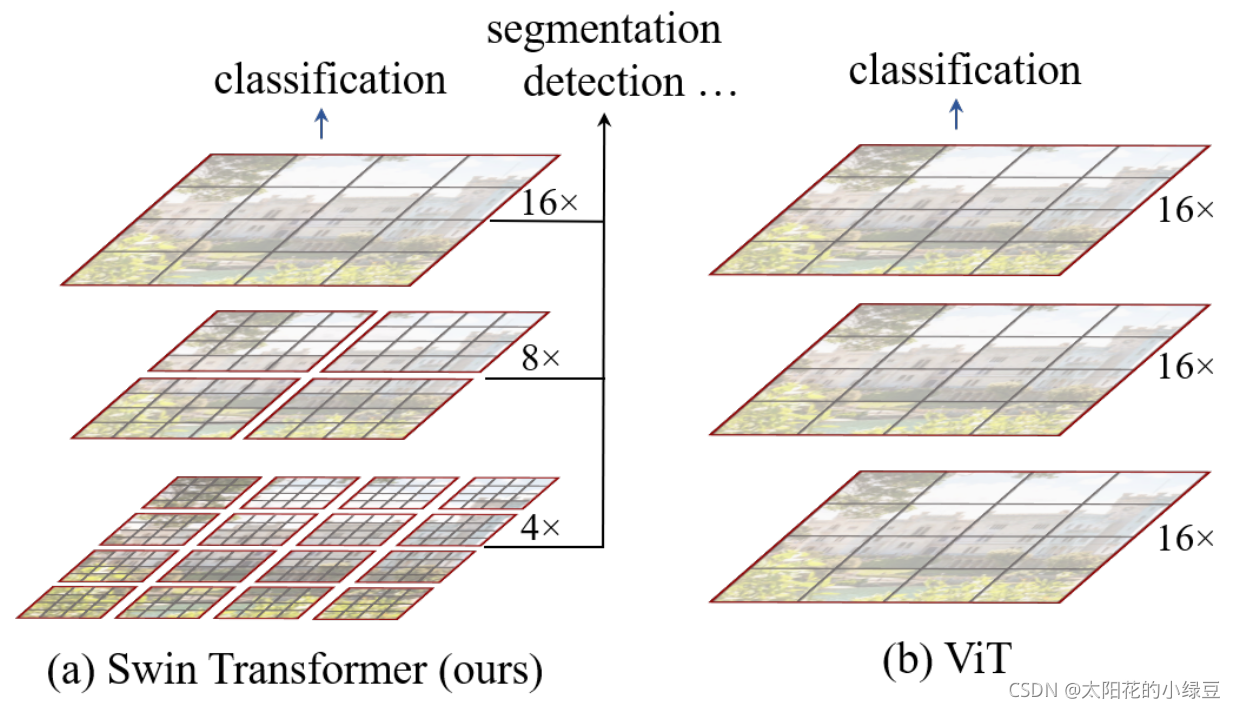

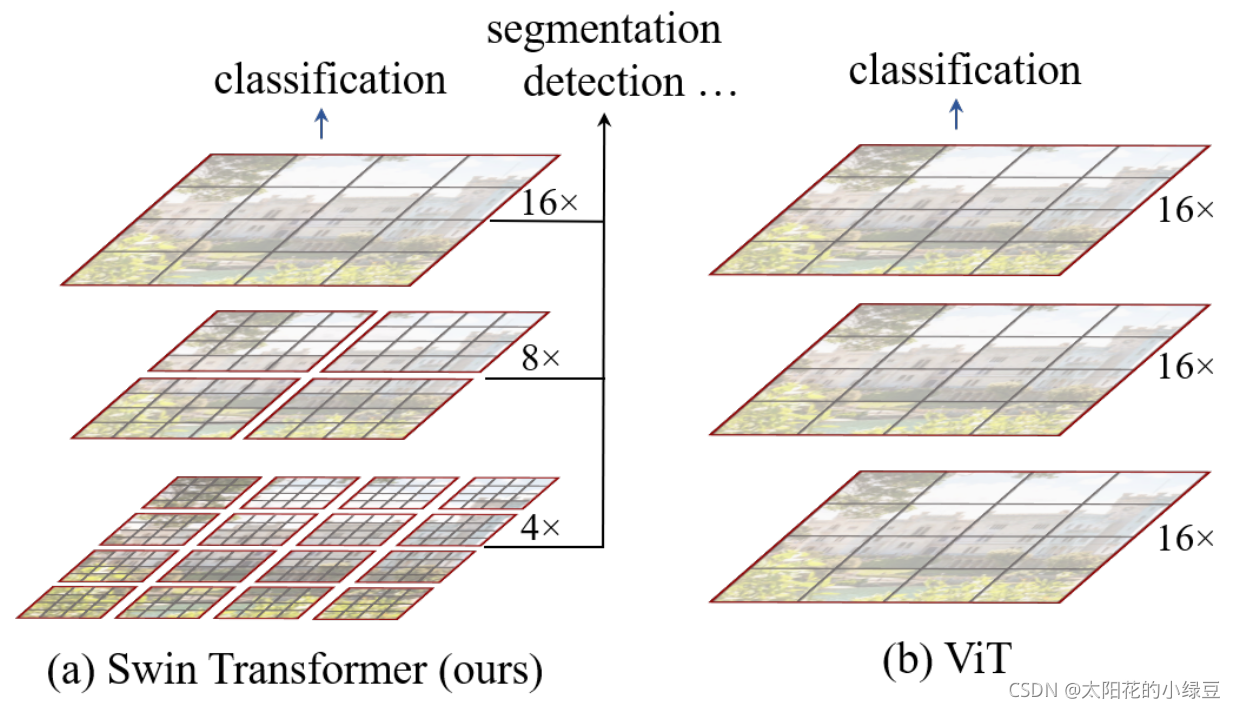

2)SWIN

SWIN Transformer是微软发布的视觉领域Transformer模型[12],SWIN Transformer使用层次化构建方法,相比Vision Transformer(ViT)能够更好地完成构建目标检测、实例分割等任务,且大大减少了计算量,提高模型性能。

图9 Swin Transformer与ViT对比[13]

3)DINO

DINO(DETR with Improved deNoising anchOr boxes)是Meta公司研究的一项自监督学习算法[14],能够在无监督情况下训练Vision Transformer。在计算机视觉中,分割对象有助于简化各种任务,传统上是通过监督学习来完成的,并且需要大量带注释的示例,而DINO结合Vision Transformer的自监督学习和合适架构可以实现高度准确的分割,提高模型识别效率和准确率。

4)Scaling ViT

Scaling ViT是一项谷歌公司对ViT模型的规模参数研究[15]。Scaling ViT对ViT模型和数据进行缩放,改进ViT的架构和训练方式,减少了内存消耗并提高了结果模型的准确性。在此基础上谷歌公司训练了一个拥有20亿参数规模的ViT-G模型,其在许多计算机视觉基准测试中取得了先进的结果。

5)Dist. Shift

Distribution shifts(分布偏移)是数据集(状态-动作对)的分布和想要评估的策略所遵循的分布之间的差异[16]。在训练过程中,Distribution shift会导致学习的策略离想要得到的行为策略越来越远。为此,研究者提出一个框架以对此进行分析,从而找出鲁棒性最好的训练方法。

6)ViT Slimming

ViT Slimming是对ViT模型的算法优化。通过优化裁剪算法,ViT Slimming可以同时减少模型参数量和计算量,减少搜索时长和资源耗费,提高模型性能和效率[17]。

7)SAM

传统的分割模型针对特定的任务、类别、数据类型等进行训练,无法适应多样化的分割任务,并且需要昂贵的注释成本。SAM(Segment Anything Model)是Meta公司研究的一个开源的通用图像分割大模型[18],其基于语言模型完成可提示的分割任务,具有强交互和各种图像分割任务的能力,结合10亿参数量标记分割数据集(SA-1B),SAM在各种分割任务中实现了最先进的性能。

8)SegGPT

SegGPT是北京智源人工智能研究院推出的通用图像分割大模型[19],与SAM的交互分割方式不同,SegGPT利用提示(prompt)完成任意目标的分割,其将各种分割任务统一成一个通用的上下文学习框架,可用于分割上下文中的所有事物。通过利用任务定义的灵活性和上下文推理,SegGPT能在图像/视频分割中实现更多样化的应用。

9)DINOv2

DINOv2是Meta公司发布开源自监督ViT模型[20],其基于DINO进行优化,可以直接从图像中学习特征而不依赖文本描述,其背后根据网络爬取数据组装和整理了包含1.42亿张图像的大型预训练数据集,涵盖许多关键视觉领域,提高了特征的质量以及预训练的效率。DINOv2可直接进行几乎所有CV任务而不需要微调,如图像分类、分割、图像检索和深度估计。

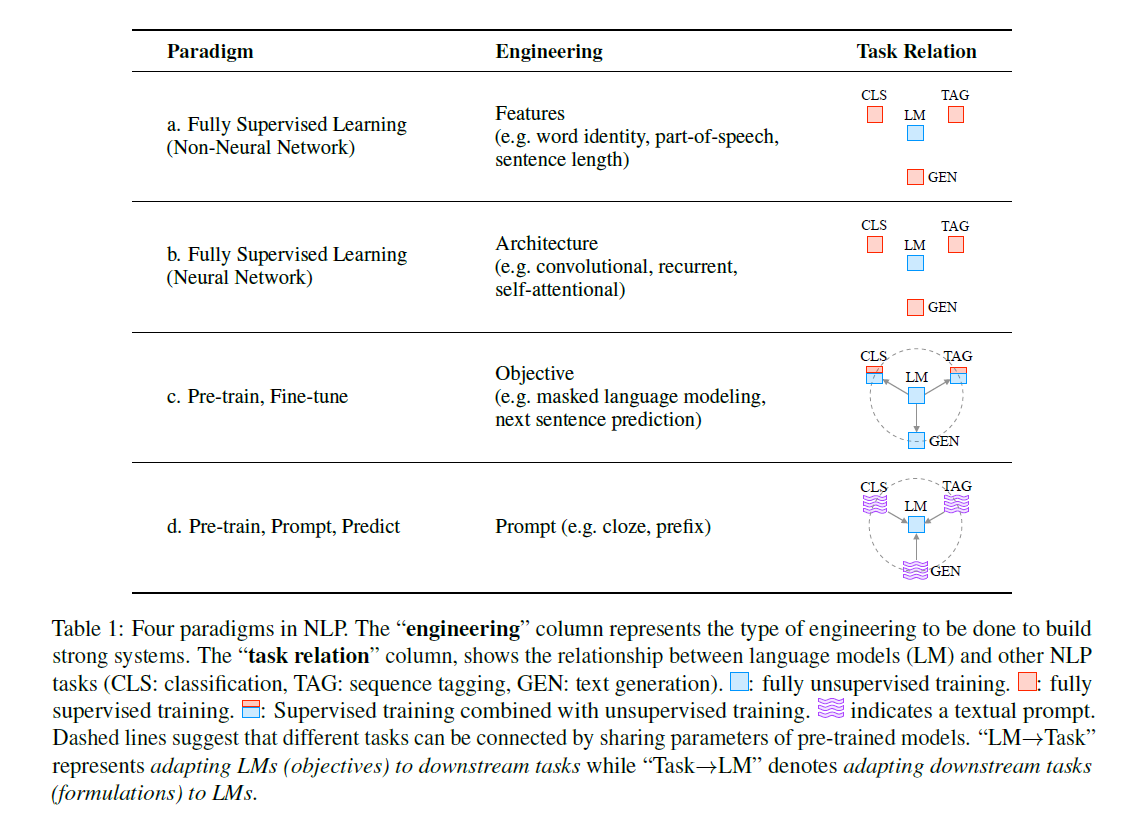

10)Visual prompting

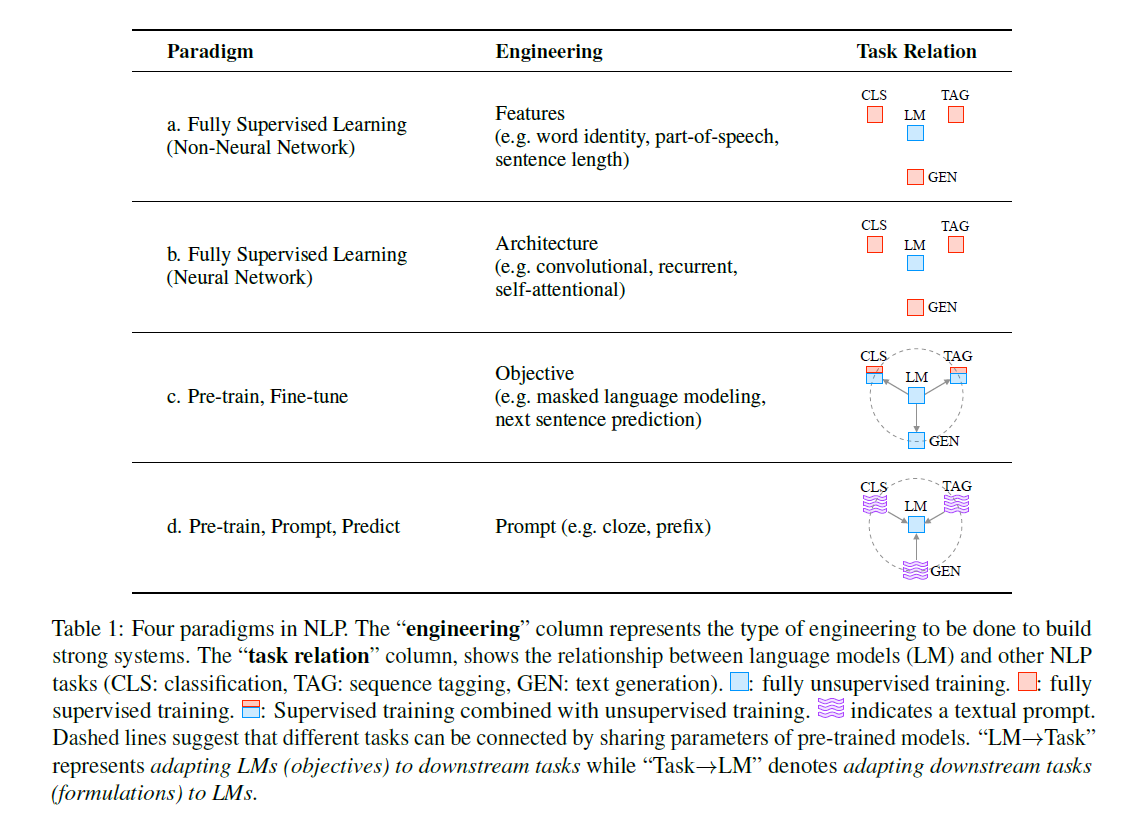

Visual prompting是一种基于视觉提示(prompt)生成图像的方法[21]。通过利用文本到图像扩散模型的丰富预训练编辑能力,将视觉提示转化为编辑指令。我们以NLP领域为例,CV领域的发展历程与之类似:从依赖特征工程的传统机器学习,到大量依赖数据集的深度学习,再到基于预训练模型的Fine-tune类型算法,再到现在的基于预训练模型的Prompt类型算法。

图10 NLP的发展历程[22]

2.幻觉难题与智能程度

“幻觉”是指ChatGPT等AI聊天机器人会用自行编造虚假信息进行回应,这些幻觉在需要多步骤推理的领域尤其严重。这是因为基于文本训练的大型语言模型只能理解片面的真实世界知识,它们回答的依据来自将整个真实世界压缩成文本进行训练后所形成的逻辑关系,而不是直接来自对物理世界本身。因此,它们缺乏对事件之间因果关系的了解,并且由于这样的预测方式本质上缺乏时间尺度,这样的模型也就缺乏真正意义上的规划和决策能力。智能被看作是一种将我们从以往经验中学到的东西应用到我们所处环境中可能出现的不同情况的能力(解释归纳),也是一种需要理解周围环境,并创建内在模型来描述环境的能力(演绎推理)。当前,生成式人工智能领域的底座都是基于Transformer架构。我们可以理解为,Transformer架构统领了一种以预训练数据规模兑换智能涌现能力——「所谓大力出奇迹」——的发展道路,并且到目前为止取得了瞩目的成果。然而,我们不能简单地将大模型的“能力”等价于它的“智能”。当前的生成式人工智能模型是一系列优秀的因果关系解释器,但幻觉难题却显示它们并不是好的因果关系推理器,因此这些模型无法真正地单单依靠大规模输入数据预训练来实现“智能”。假设生成式人工智能可以最终通往AGI,那么这条道路到底是数据驱动模型,还是模型驱动数据,亦或者是两者并取的姿态?这是未来需要解决的问题。关于幻觉难题,OpenAI公司也在近期宣布将使用新的训练方式来帮助GPT进行迭代,技术方向为在训练过程中引入强化学习机制,增强逻辑能力。另外,OpenAI公司发布的ChatGPT插件Code Interpreter(代码解释器)也有助于改善幻觉问题,当AI直接与Python代码一起工作时,代码有助于让AI保持「诚实」,因为代码不正确时,Python会产生错误。

二、AGI产业链纵横延伸

图11 生成式人工智能产业链纵横延伸图(团队整理)

(一)芯片层

《中国算力指数发展白皮书(2022)》显示,中、美两国在全球算力规模中的份额分别为33%、34%,其中:通用算力份额分别为26%、37%;智能算力分别为28%、45%;超级算力分别为18%、48%。生成式人工智能时代,算力已然成为硬通货。

1.英伟达

(1)行业信息

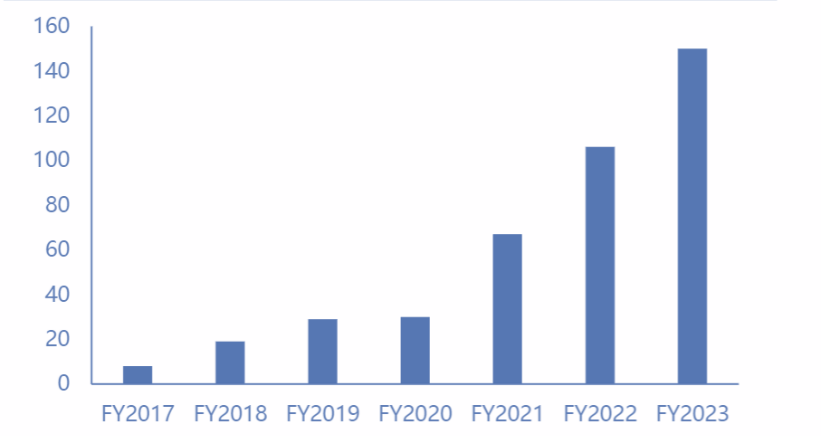

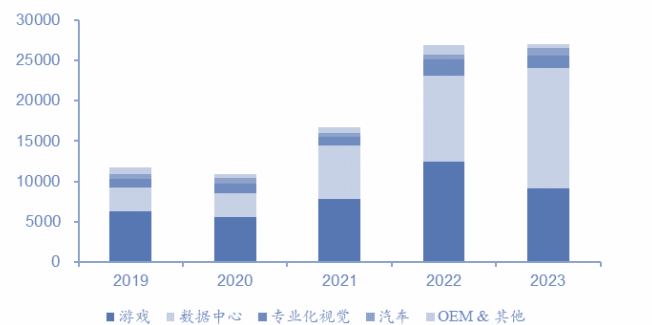

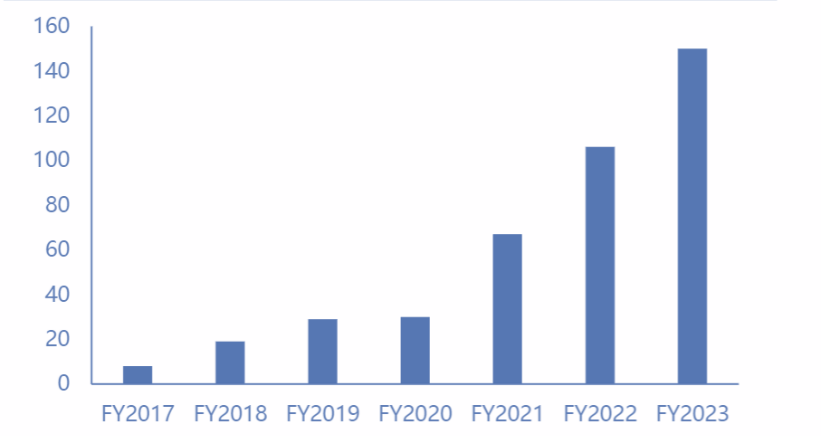

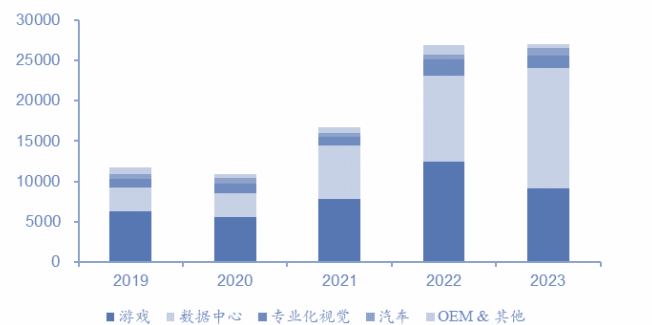

图12 2017-2023财年英伟达数据中心营收(亿美元)

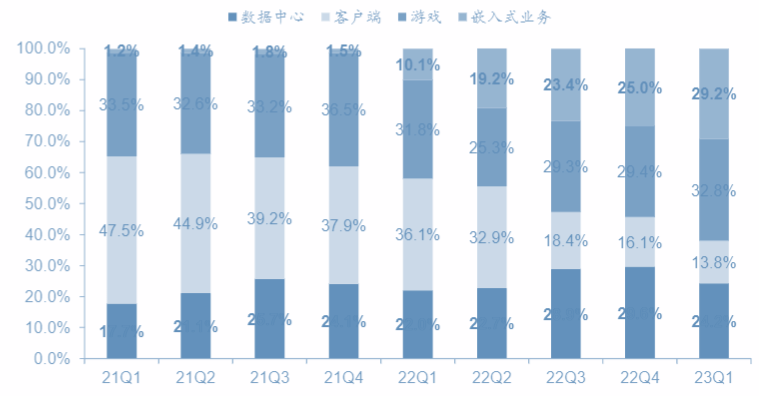

图13 2019-2023财年英伟达分业务收入(万美元)随着人工智能发展,英伟达的AI与数据中心业务收入快速上升,在主营业务里增速最高,逐步成为英伟达最大营收占比。2023年,英伟达数据中心营收占比达到了56%。

(2)政策信息

2022年9月1日,美国商务部限制英伟达向中国出口A100和H100两款芯片,以及未来算力达到或超过A100水平的人工智能芯片。近期,美国正在考虑进一步出台面向中国的AI芯片出口新限制。目前,国内训练大模型的企业混合使用不同的芯片,一些公司将英伟达的V100和P100,以及华为自研的Ascends芯片组合使用,可以在一定程度上实现A100和H100的工作效果。2023年8月,美国对AI芯片出台新的管制措施,其中尤其包括英伟达的特供版芯片A800。2023年8月28日,英伟达在一份报告中指出,“2024财年第二季度,美国政府通知我们,对运往某些客户和其他地区(包括中东一些国家)的A100芯片和H100芯片的部分产品提出了额外的许可要求。”

(3)核心技术与产品

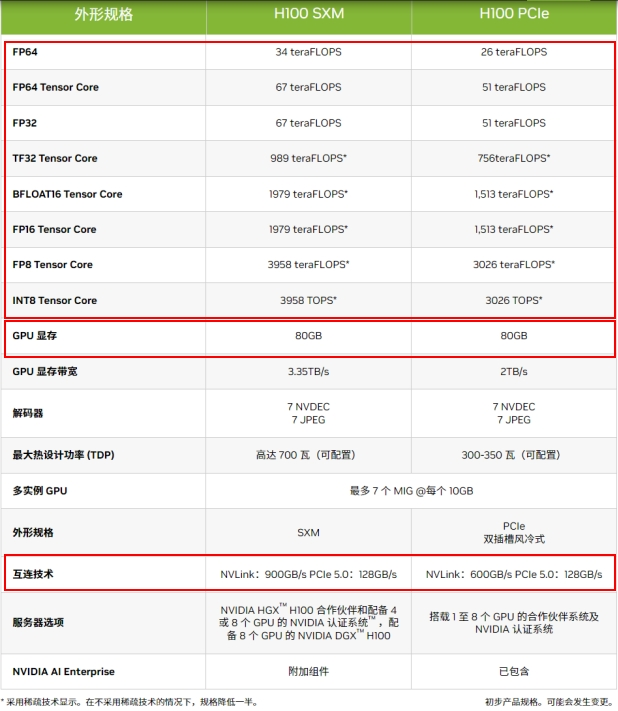

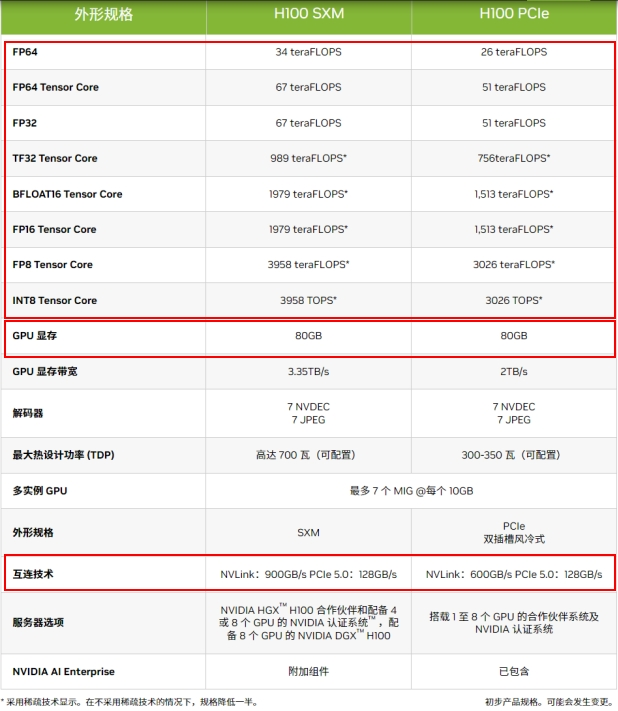

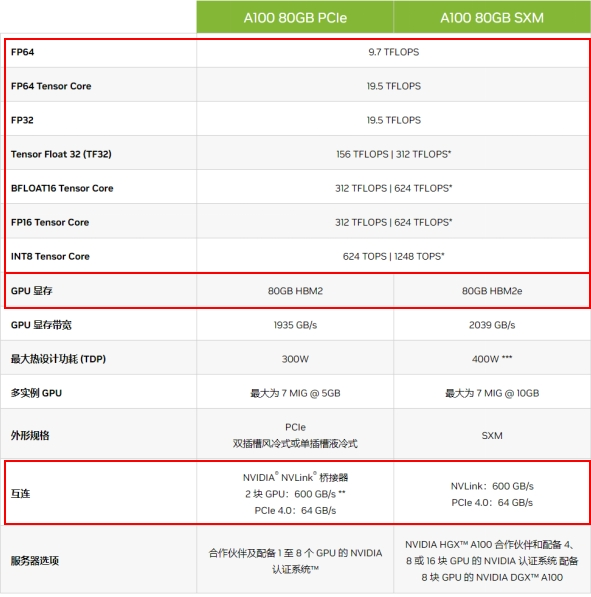

GH200:2023年最新发布,由256片NVIDIA Grace Hopper芯片组成,计算性能达到1-Exaflop、拥有144TB内存,相比上一代NVLink带宽提升48倍以上。谷歌、Meta及微软公司是首批有望接入DGX H200系统的公司。H100 & H800:H800为英伟达即将发售的中国特供版本,据相关媒体报道,英伟达可能会将同型号H100的NVLINK带宽降低一半左右来满足出口管制法规。

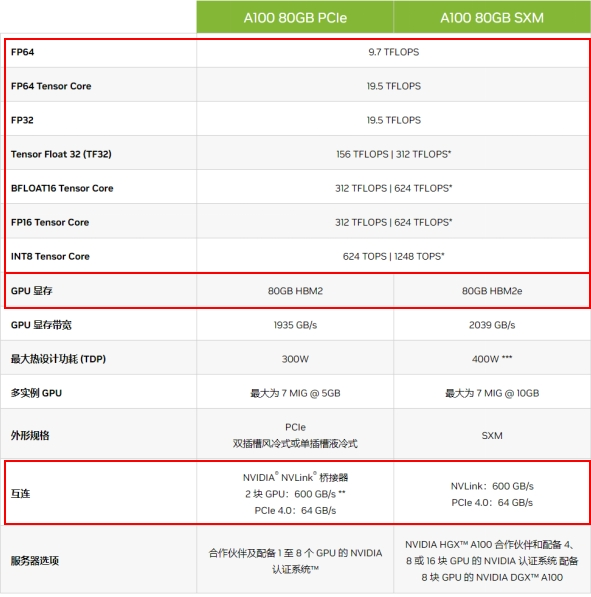

图14 英伟达H100参数规格(英伟达官网)A100 & A800:A800为英伟达发售的中国特供版本,在性能与A100基本一致的情况下,英伟达将A800的NVLINK带宽降为400GB/s,限制了A800的大规模拓展互联性能。

图15 英伟达A100参数规格(英伟达官网)

(4)运营情况

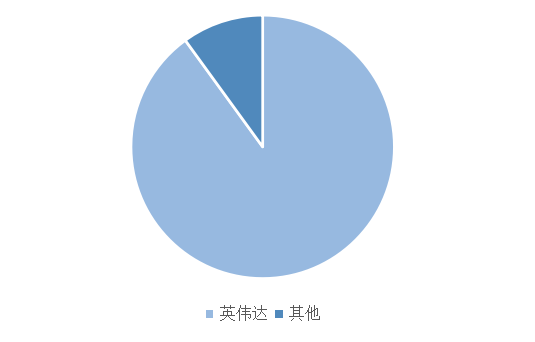

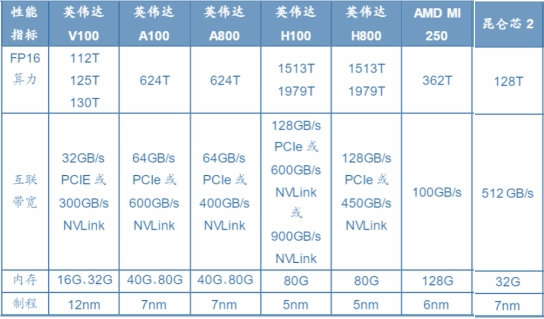

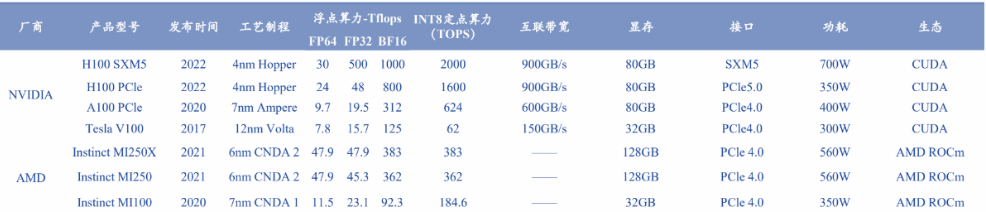

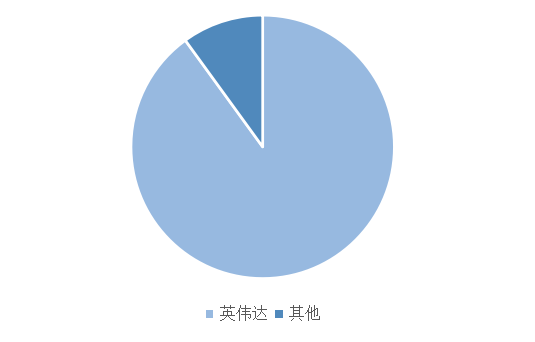

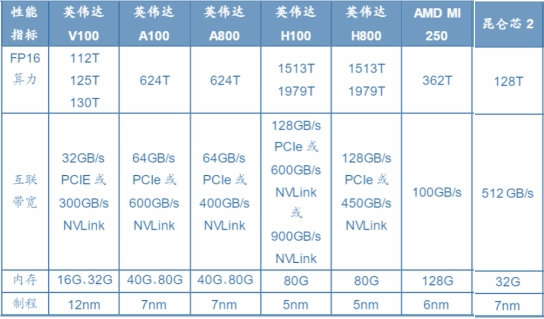

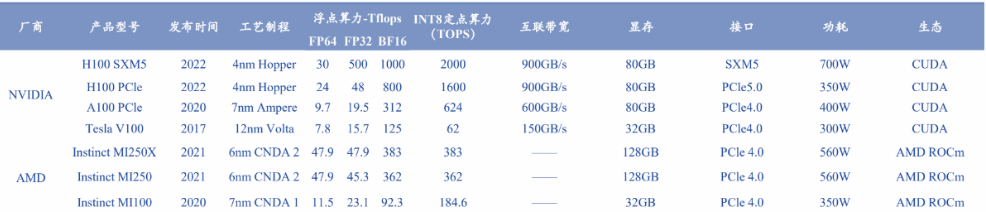

图16 2022年中国AI芯片市场占有率

图17 主流AI训练芯片性能对比根据2022年中国AI芯片市场占有率统计,英伟达在中国国内AI芯片市场占有率超过90%。1)算力方面,国产AI芯片与英伟达旗舰AI芯片性能差距较大,且国内厂商大多不支持双精度(FP64)计算,在单精度(FP32)及定点计算(INT8)方面与国外中端产品持平;2)接口方面,壁仞科技与英伟达率先使用PCle5.0,其他厂商多集中在PCle4.0;3)制程方面,目前英伟达到达4nm,而台积电率先到达3nm,国内厂商多集中在7nm;4)生态方面,国内企业多采用OpenCL进行自主生态建设,与英伟达CUDA的成熟生态相比,差距较为明显。随着新一代AI芯片GH200的发布,英伟达在芯片性能与应用生态上将与国内AI芯片企业进一步拉开更大差距,不断定义行业龙头发展。

2.AMD

(1)运营情况

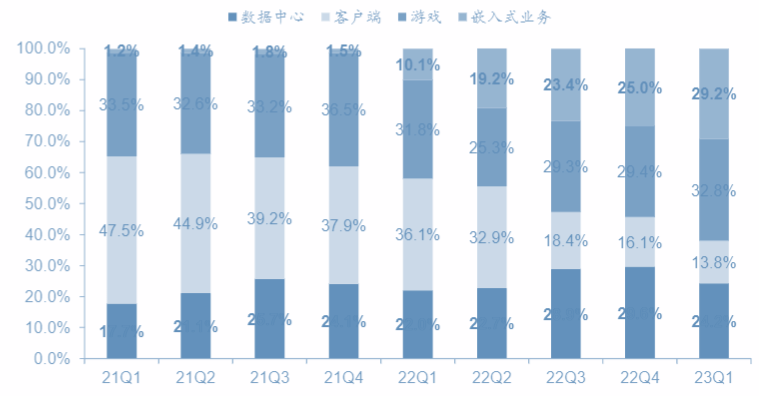

图18 AMD季度分业务占比2023年第一季度,AMD数据中心业务占比有所下降,AI芯片出货量不及预期;第二季度数据中心业务营收略微回升,但与去年同期相比仍有所下降。2023年6月,AMD发布新一代AI芯片MI300系列,并宣布与独角兽AI企业Hugging face合作。AMD还与Amazon Web Services、Microsoft Azure、Google Cloud等公司合作,为客户提供数据中心解决方案。在AI芯片与数据中心服务板块方面,一直被视作英伟达在芯片领域最强劲对手的AMD的表现没有达到预期。AMD并没有获得许多大型企业的AI芯片订单,在最近一次的大型发布会上,AMD发布最新一代AI芯片,但也仅仅宣布与一家AI独角兽企业进行战略合作。在AI芯片性能以及平台生态部署上,AMD与英伟达还存在一定的差距。

(2)政策信息

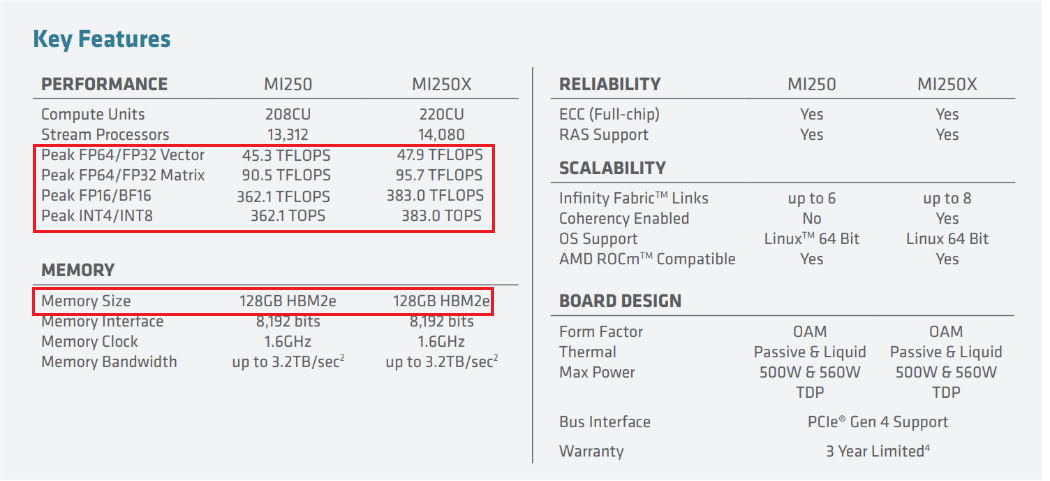

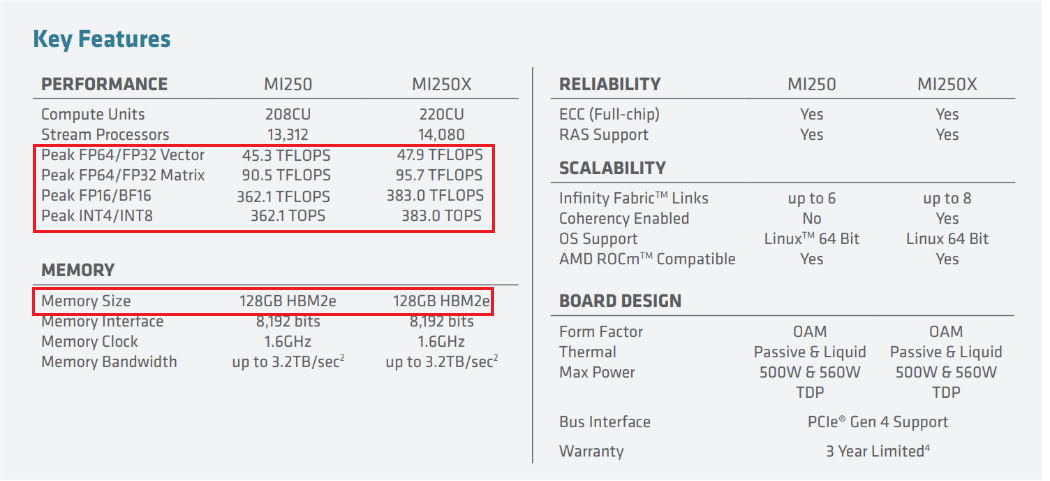

美国商务部要求AMD停止向中国出口MI250芯片,但是AMD表示MI100芯片并不受影响。AMD考虑将其MI300和旧版MI250芯片产品出口到中国市场。

(3)核心技术与产品

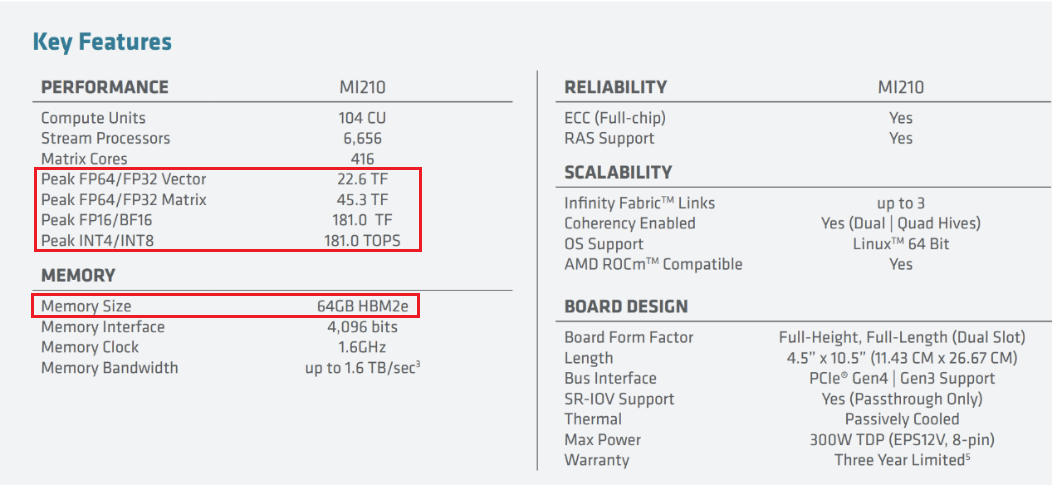

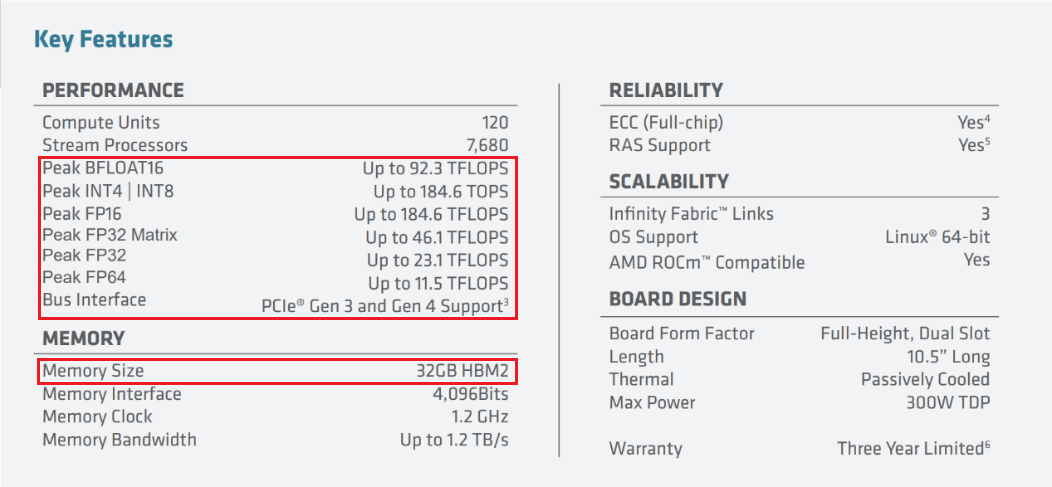

AMD Instinct MI系列加速器:MI300系列(2023年最新发布,其AI性能预计是上一代MI250的8倍);MI200系列;MI100系列。

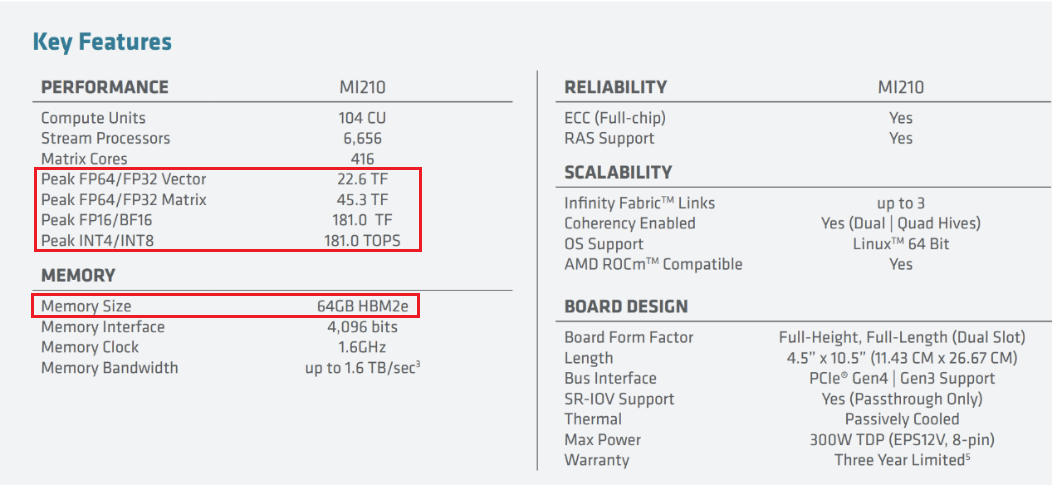

图19 MI210系列参数规格(AMD官网)

图20 MI250系列参数规格(AMD官网)

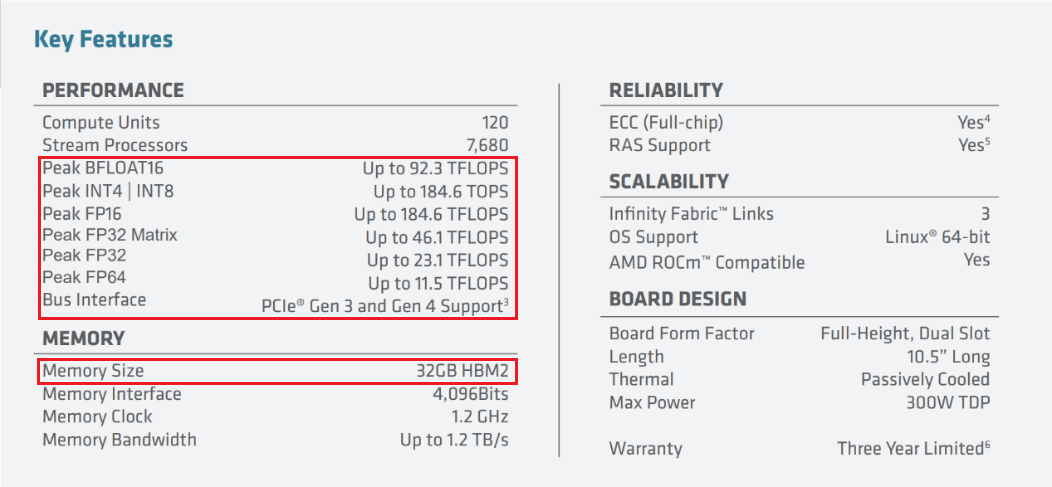

图21 MI100系列参数规格(AMD官网)

图21 英伟达与AMD主流AI芯片对比

3.昆仑芯

昆仑芯科技成立于2011年,前身为百度智能芯片及架构部,于2021年4月完成独立融资,首轮估值约130亿元人民币。昆仑芯科技专注于AI加速领域,拥有自主研发的XPU架构,实现了两代通用AI芯片的量产和落地应用。昆仑芯的主要产品有2代/1代AI芯片、R系列和K系列AI加速卡。昆仑芯1代AI芯片可用于云数据中心和智能边缘,支持全AI算法。2代AI芯片是国内首款采用GDDR6显存的通用AI芯片,支持虚拟化、芯片间互联和视频编解码等功能。

4.灵汐科技

灵汐科技是一家全球领先的类脑计算技术科技公司,成立于2018年,前身为清华大学类脑计算研究中心。灵汐科技是全球首个成功研发异构融合类脑芯片的AI芯片公司,其拥有自主研发的XPU架构,基于异构融合、存算一体、众核并行的设计理念,开发出了一系列类脑计算芯片、模组、板卡、服务器和软件平台。灵汐科技的主要产品有类脑芯片处理器领启KA200系列,以及类脑计算模组、类脑计算加速卡、类脑计算服务器以及边缘产品等应用。

5.瑞芯微电子

瑞芯微电子成立于2001年,专注于集成电路设计与研发,目前已发展为领先的物联网(IoT)及人工智能物联网(AIoT)处理器芯片企业。瑞芯微在处理器和数模混合芯片设计、多媒体处理、影像算法、系统软件开发上具有丰富的经验和技术储备。瑞芯微主要AI芯片产品有AI加速卡RK1808、边缘计算芯片RK3399pro等。

6.清微智能

清微智能是可重构计算(CGA)领导企业,全球首家且出货量最大的可重构计算芯片商用企业。核心团队来自于清华大学集成电路学院,专注于可重构计算芯片的创新研发和产业应用,面向AI训练、推理,NLP,自动驾驶,生物计算等通用计算场景,提供高性能算力支持,致力于打造自主可控的可重构通用计算生态。清微智能的主要产品有TX8大算力芯片、TX5智能图像芯片、TX2耳机主控芯片等多种类型芯片。

(二)架构层

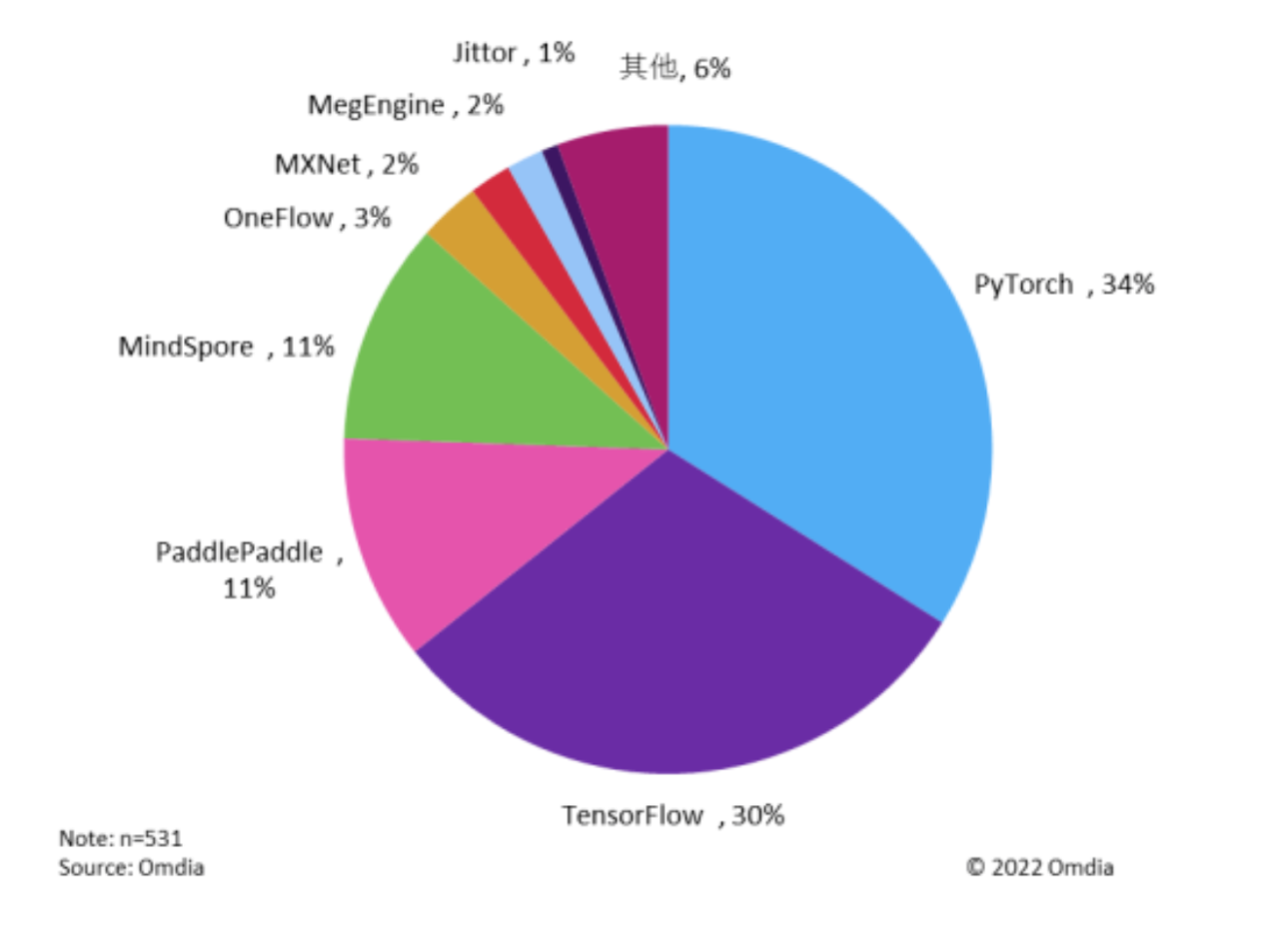

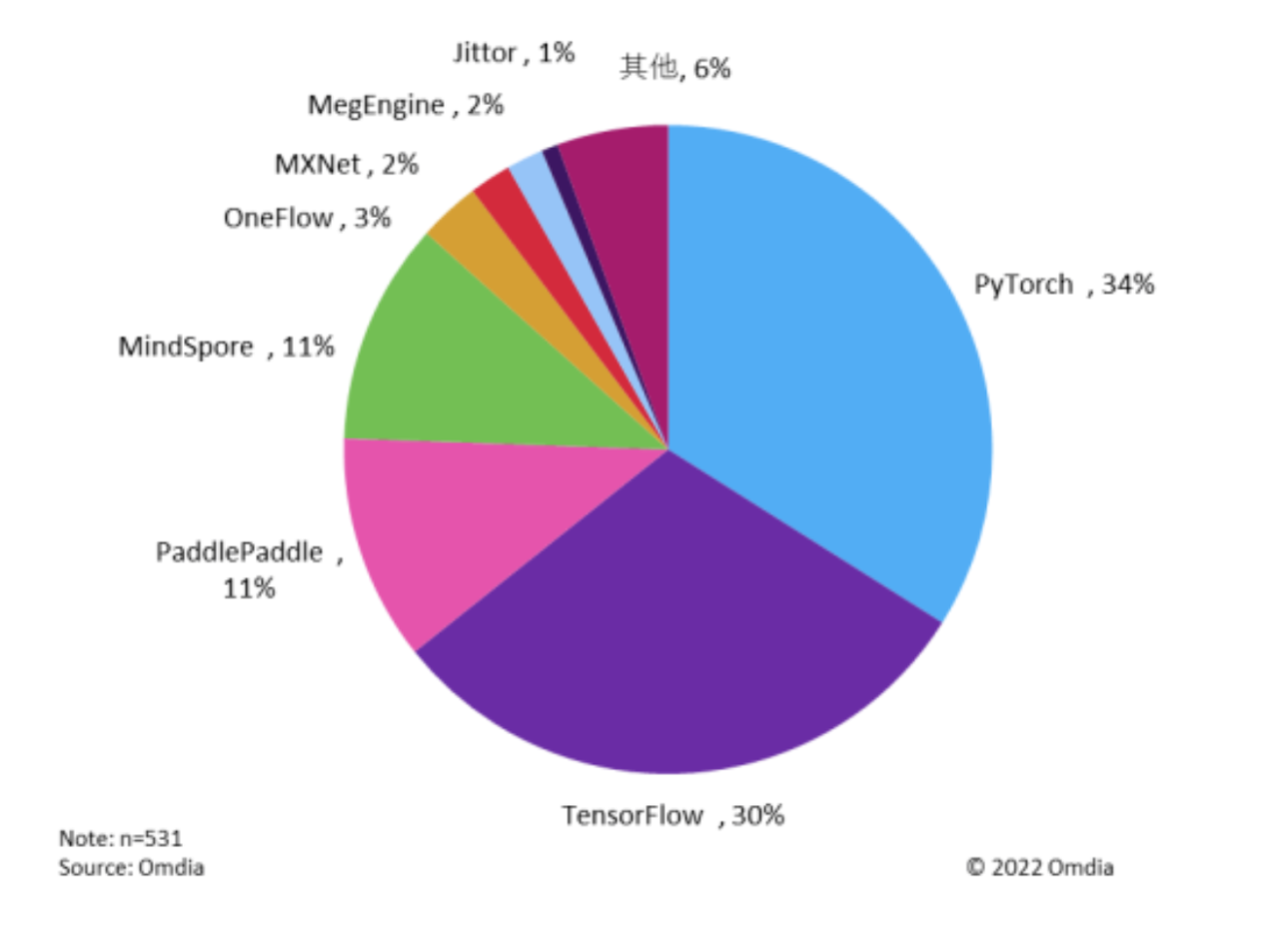

1.Meta-Pytorch

Meta-Pytorch是一个开源的深度学习框架,由Meta公司和AI社区共同创建,用于AI研究和生产。Meta-Pytorch提供了张量计算、自动微分、优化算法、神经网络层等功能,用于少样本学习和元学习,解决数据稀缺或多任务的问题,如少样本回归、少样本分类、少样本分割等。Meta-Pytorch还用于深度学习研究和开发,用于构建、训练、部署和运行各种AI和机器学习模型,如自然语言处理、计算机视觉、语义分割等,并且支持在手机和电脑上运行,是AI社区的领先平台之一。Meta-Pytorch还受到了Linux基金会的支持。2022年9月,该项目被转移到Linux基金会下的一个独立的PyTorch基金会。

2.Google-Tensorflow/Keras

TensorFlow是一个开源的深度学习框架,由Google Brain团队于2015年发布,用于支持谷歌公司的AI研究和产品。TensorFlow提供了张量计算、自动微分、分布式训练、模型部署等功能,以及一些用于不同深度学习任务的库和工具。Keras是基于Tensorflow的一个更深层次的深度学习API,被集成到Tensorflow中,用于简化和加速深度学习模型的构建和训练。TensorFlow和Keras是目前最流行和最广泛使用的深度学习框架之一,拥有庞大的社区和生态系统,支持多种硬件和云平台,以及多种深度学习任务。TensorFlow和Keras也是谷歌公司主要的AI平台,用于支持其各种AI产品和服务。TensorFlow和Keras广泛应用于以下方面:深度学习研究和开发,用于构建、训练、部署和运行各种AI和机器学习模型,如自然语言处理、计算机视觉、语义分割等;计算机视觉和自然语言处理,用于解决图像分类、目标检测、文本生成、文本分类等问题;大规模语言模型,用于训练和运行如GPT-3、BERT等模型,使用分布式训练技术。

3.英伟达-Megatron

Megatron是一个基于PyTorch的开源框架,用于训练基于Transformer架构的大规模参数量的语言模型。Megatron框架使用先进的训练技术,如模型并行(张量、序列和流水线)和多节点训练,以最大化吞吐量和最小化训练时间。同时,Megatron还提供多种定制技术,可以优化不同模态(如文本、图像)的基础模型。Megatron支持在任何GPU基础设施上训练和部署基础模型。Megatron对AI行业有着重大影响,它为企业提供了一个快速、高效和灵活的方式来开发和部署具有强大表达能力和泛化能力的语言和图像生成AI模型。这些模型可以应用于各种场景,如实时转录、翻译、聊天机器人、虚拟助理、内容生成等。Megatron还提供了一个开源的研究平台,用于进一步探索大规模Transformer语言模型的训练方法。

4.百度-Paddle

Paddle飞桨是百度公司自主研发的深度学习平台,于2016年正式开源,是中国首个自主研发、功能完备、开源开放的产业级深度学习平台。Paddle飞桨集深度学习核心框架、基础模型库、端到端开发套件、工具组件和服务平台于一体,支持多种场景的深度学习应用,如语义理解、图像分类、目标检测、语音合成。Paddle拥有多项领先的技术创新,比如支持动静态图编程的Paddle Paddle2.04,支持万亿规模参数模型训练的Paddle Distributed Training4,支持多端多平台部署的高性能推理引擎Paddle Inference4,以及覆盖多个领域和场景的产业级开源模型库PaddleHub4。Paddle飞桨还支持低代码开发工具PaddleX4,让AI开发变得更加简单和高效。Paddle飞桨框架广泛应用于各个场景,如目标检测、自然语言处理、计算机视觉。截至2022年12月,中国信通院最新报告显示,Paddle飞桨已成为中国深度学习市场应用规模第一的深度学习框架和赋能平台。

5.一流科技

一流科技(OneFlow)是一个开源的深度学习框架,成立于2018年,开始开发OneFlow的核心技术,包括:异构分布式流式系统、动态控制流、自动并行等。2020年,OneFlow正式开源,并发布第一个稳定版本,支持常见的深度学习模型和任务,如图像分类、目标检测、自然语言处理等。2021年,OneFlow增加许多新功能和特性,如Eager模式、混合精度训练、模型压缩、预训练模型库等。OneFlow采用了一种基于Actor模型的异构分布式流式系统,可以将计算图划分为多个子图,并将其分配给不同类型的计算设备(如CPU、GPU、TPU等),实现高效的并行执行和通信。它还支持动态控制流,提供自动并行机制,支持两种编程模式,并提供丰富的预训练模型库。OneFlow与字节跳动、旷视科技、华为云等企业合作,在多个应用场景中取得了显著的成功,如视频编解码、图像超分辨率、语音识别;人脸识别、人体姿态估计、视频分析;自然语言处理、计算机视觉、推荐系统等领域。OneFlow还与清华大学、北京大学、中国科学院等高校和研究机构合作,开展多项基础研究和应用研究,如自然语言生成、图像生成、自动驾驶等。2023年3月,原美团联合创始人王慧文创立的新项目“光年之外”通过并购方式将一流科技引入麾下;2023年6月,美团发布公告称以约20.65亿元人民币的价格,完成对光年之外的股权收购。

6.华为-MindSpore

MindSpore是华为公司推出的新一代深度学习框架,源于全产业的最佳实践,最佳匹配昇腾处理器算力,支持终端、边缘、云全场景灵活部署,开创全新的AI编程范式,降低AI开发门槛。MindSpore在支持算子级自动微分的同时,对反向算子进行IR层面的优化,满足算子开发者自动生成反向算子的需求。同时,MindSpore兼顾用户对手动调优反向的需求,将自动和手动有机结合,简化了开发流程,提升了代码的可读性,增加了代码的运行效率。端云协同MindSpore依托华为“端—边—云”的业务场景,在隐私保护日渐重要的情况下,致力于支持全场景部署,并打通云到端全流程。MindSpore针对全场景提供一致的开发和部署能力,以及按需协同能力,让开发者能够实现AI应用在云、边缘和手机端上快速部署,全场景互联互通,实现更好的资源利用和隐私保护,创造更加丰富的AI应用。

图23 中国开发者主流人工智能框架使用率排名

(三)模型层

我们将从模型简述、具体功能、运行效率、商业化程度、适用行业等几方面进行分析。

1.OpenAI-ChatGPT/GPT-4

(1)模型简述

ChatGPT是基于GPT-3.5架构的大型语言模型,训练参数量达1750亿。2023年3月OpenAI发布GPT-4,训练参数量为GPT-3的10倍,达到1.8万亿个参数,具有更强大的自然语言处理能力,并支持文本和图像混合输入的多模态能力。

(2)具体功能

自然语言理解——ChatGPT可以理解人类语言的含义,包括问题、陈述、命令等,并能够提取出关键信息进行处理。问题回答——ChatGPT可以回答关于各种主题的问题,提供相关的信息、解释、定义和示例等。它能够利用它在训练过程中学习到的广泛知识库来支持问题的回答。文本生成——ChatGPT可以生成连贯的、有逻辑的文本段落。无论是生成故事、描述场景、撰写文章、写作建议,还是进行创造性的文本创作,它都能提供合理的、有意义的输出。对话交互——ChatGPT能够进行与用户的实时对话交互。它可以处理多轮对话,记住之前的上下文,并根据用户的问题或回应做出适当的回答。多模态能力(GPT-4)——可以输入/生成多种不同形式的数据,例如图像、语音、文本等。多模态能够提升交互效率,扩展模型的应用场景,完成更多新型任务。

(3)商业化程度和使用行业

图24 OpenAI旗下模型商业化应用(微软官网)OpenAI公司推出MaaS(模型即服务)商业模式,针对旗下模型开发商用API服务,让下游客户通过API调用模型能力;搜索引擎New Bing全面接入GPT-4;基于GPT-4的人工智能助手Copilot被内置到Microsoft 365中,可以帮助用户在Word、Excel、PowerPoint、Outlook等应用中生成文本、转换文档、获取摘要等功能,例如在PowerPoint中,它能够通过自然语言命令将想法转化为设计好的演示文稿;Be My Eyes是一款帮助全世界的盲人以及低视力人群的产品,其接入GPT-4运用视觉输入功能,能够大幅度提高对图片的理解程度;语言学习软件Duolingo推出GPT-4驱动的DuolingoMax,能够辅助用户解释答案对错,以及陪同用户进行角色扮演式地练习,目前已在数字商务、智能制造、MaaS云服务、办公软件、数据分析、聊天机器人等行业有所应用。

2.Google-Bard/Deepmind

(1)模型简述

Bard是谷歌公司在大型语言模型基础上推出的聊天机器人。PaLM是谷歌公司在2022年4月发布的大语言模型,使用了5400亿参数进行训练。新版本的PaLM 2在PaLM上进一步进行了提升和改进,使用1.56万亿个参数训练,具有多语言、推理和编码功能。Bard当前基于最新的PaLM2模型。面向开发者,谷歌公司开放PaLM的API,并发布工具MakerSuite,帮助开发者们快速构建生成式AI应用。

(2)具体功能

PaLM 2相比PaLM拥有更强的多语言文本处理能力、逻辑、常识推理和数学能力以及代码能力。PaLM 2拥有四种规格,从小到大依次为Gecko、Otter、Bison和Unicorn。其中体积最小的Gecko可以在手机上运行,每秒大约可处理20个token,也就是约16或17个单词。

(3)商业化程度和使用行业

PaLM 2赋能超25种功能和产品的升级,包括办公套件、聊天机器人(搜索引擎),以及企业级AI平台。在PaLM 2的加持下,Workspace推出AIGC工具包Duet AI,其中包含Google Docs和Gmail中的智能写作工具、Google Slides中的文本生成图像、演讲备注,以及Google Meet的会议摘要生成等功能。

(4)Deepmind的专有领域模型

1)AlphaZero-AI棋手

AlphaZero是针对棋类游戏的强化学习算法。它可以在没有人类监督的情况下,自动地从对弈数据中不断总结经验、从零开始学习最优的下棋策略,最终探索和设计出新的国际象棋套路。

2)AlphaTensor、AlphaDev-AI发现算法

AlphaTensor是第一个可用于为矩阵乘法等基本任务发现新颖、高效且可证明正确的算法的人工智能系统,基于AlphaZero发展而来。AlphaTensor找到了两个矩阵相乘最快的方法——这是一项50年来在数学领域悬而未决的问题。由于矩阵乘法是计算机图形学、数字通信、神经网络训练和科学计算等很多计算任务的核心组成部分,AlphaTensor发现的算法可以显著提升这些领域的计算效率。DeepMind的研究还表明,AlphaZero这种强大的算法远远超出了传统游戏的领域,可以帮助解决数学领域的开放问题。AlphaDev同样基于AlphaZero,其发现了一种比现有最佳方法快70%的方法来对列表进行排序。AlphaDev的算法被添加到C++语言中,这是十多年来对C++排序算法的首次修改,也是第一次涉及使用人工智能发现的算法的更新。

3)AlphaCode-AI编程

AlphaCode是一种人工智能编程工具,该工具可以像真实参加竞赛的程序员一样,参加各大编程竞赛,并且还可以结合批判性思维、逻辑、算法、编码和自然语言理解的新问题来提供解决方案。AlphaCode在参加10场编程比赛后获得了超过一半人类程序员的成绩。

4)RT-2(Robotic Transformer)—机器人的Transformer模型

图25 RT-2部署至机器人(谷歌官网)RT-2是2023年7月发布的全球第一个控制机器人的视觉-语言-动作(VLA)模型,RT-2模型基于网络和机器人数据进行训练,利用Bard等大型语言模型的研究进展,并将其与机器人数据相结合。RT-2最突出的特点是不再需要用复杂指令,而是像ChatGPT一样直接用自然语言就能操纵。在此之前,训练机器人需要很长时间,研究人员必须为不同任务单独建立解决方案,而借助RT-2的强大功能,机器人可以自己分析更多信息,自行推断下一步该做什么。RT-2创造了一种新的概念:视觉-语言-动作(VLA)模型,它可以从网络和机器人数据中进行学习,并将这些知识转化为机器人可以控制的通用指令。该模型甚至能够使用思维链提示,比如哪种饮料最适合疲惫的人——能量饮料。RT-2的训练原理可以简单概括为:为了使视觉-语言模型能够控制机器人,需要将其与动作控制建立连接。该研究将机器人动作看作另一种“语言”,并与视觉-语言数据集一起进行训练。

图26 VLA模型示意(谷歌官网)

5)Google*DeepMind双子星计划

2023年,DeepMind和Google Brain合并为Google*DeepMind,并且正在开发一个新的名为Gemini(双子星)的项目,目标是打造一个参数超1万亿的大语言模型,据称这个算法将超越GPT-4的性能。

3.Meta-LLaMA/LLaMA2

(1)模型简述

LLaMA2是开源社区最强大的模型之一,系列包含70亿、130亿和700亿三种参数变体。相比于LLaMA1,LLaMA2的训练数据多了40%,上下文长度也翻倍,并采用了分组查询注意力机制。

(2)具体功能

目前,Meta公司提供了免费可商用版本LLaMA2模型。根据第三方测评,LLaMA2在基础语言能力、知识水平和理解能力上已经较为接近ChatGPT,而在推理能力、理解能力和学科综合能力上与ChatGPT有较为明显的差距,且目前LLaMA2的中文能力短板明显(中文语料少,没有专门针对中文进行微调),国内企业想要基于LLaMA2模型进行开发还需要进一步的训练与微调。

(3)商业化程度和使用行业

2023年7月,Meta公司发布LLaMA2的开源商用版本,意味着初创公司和广大开发者可以跳过大模型训练的预训练过程,用非常低的成本来开发自主的模型和应用,且主要针对聊天机器人和AI数字代理的开发团队。对于不依赖语言模型和不需要对模型进行微调的团队来说,LLaMA2开源的优势并不显著。LLaMA2开源也是Meta公司和OpenAI公司等大模型研发处于领先地位公司的一种竞争策略,通过免费的可商用模型抢占市场,增加竞争对手的运营维护和研发升级成本。另外,LLaMA2开源将会扩大云计算服务市场,这与Meta公司和微软公司的发展战略一致,而微软公司也在近期宣布了与Meta公司的合作。

4.百度-文心一言

(1)模型简述

2023年3月,百度公司率先发布国内第一个类ChatGPT生成式大语言模型“文心一言”,展示了其在文学创作、商业文案创作、数理逻辑推理、中文理解、多模态生成等方面的能力,并宣布已有超过650家企业宣布接入文心一言生态。同月,百度智能云发布的一站式企业级大模型平台“文心千帆”,平台提供基于文心一言的数据管理、模型定制微调、推理云等服务,助力各行业的生成式AI应用需求落地,进一步推动文心一言生态的构建。

(2)具体功能

文心一言具备文学创作、商业文案创作、数理逻辑推算、中文理解、多模态生成等功能。目前,文心一言已经升级为文心千帆大模型平台,提供先进的生成式人工智能生产及应用全流程开发工具链。

(3)运行效率

文心一言利用百度自研的昆仑芯片和飞桨深度学习框架,实现了高效的模型训练和推理。据百度官方介绍,文心一言在昆仑芯片上的推理速度是英伟达A100芯片的3倍以上。此外,文心一言还采用模型压缩、量化等技术,降低了模型部署的成本和难度。

(4)商业化程度和使用行业

百度文心大模型体系构建了文心大模型、工具与平台两层体系。在模型层,文心大模型包括基础大模型、任务大模型、行业大模型三级体系,打造大模型总量近40个,全面满足产业应用需求,涵盖电力、燃气、金融、航天等领域。基础大模型针对特定任务预训练构建任务大模型,任务大模型结合垂直领域数据和知识进一步形成行业大模型,行业大模型则在应用场景的数据反哺基础大模型进行进一步的优化;在工具与平台层,大模型开发套件、文心API,以及提供全流程开箱即用大模型能力的EasyDL和BML开发平台,帮助全方位降低应用门槛。文心大模型是目前国内预训练大模型应用端生态最好的大模型之一。在百度自有业务中,文心大规模已应用于百度内部的各类产品,包含百度搜索、度小满金融、小度智能屏、百度地图等。例如,度小满的智能征信中台将文心ERNIE大模型应用在征信报告的解读上,能够将报告解读出40万维的风险变量,以更好地识别小微企业主的信贷风险。在百度业务之外,文心大模型联合国家电网、浦发银行、中国航天、人民网等企业推出了11个行业大模型,让模型加速推动行业的智能化转型升级。例如,根据文心大模型官网,文心大模型与深圳燃气联合建立的深圳燃气百度文心大模型,在工业巡检、环境巡检场景下,准确率和召回率分别平均提升2.5%和4.5%,且所需标注数据相比传统模型下降90%,泛化能力大幅提升。

5.科大讯飞-讯飞星火

(1)模型简述

讯飞星火是科大讯飞推出的新一代认知智能大模型,拥有跨领域的知识和语言理解能力,能够基于自然对话方式理解与执行任务,从海量数据和大规模知识中持续进化,实现从提出、规划到解决问题的全流程闭环。

(2)具体功能

讯飞星火大模型具备语言理解、知识问答、逻辑推理、数学题解答、代码理解与编写等功能。

(3)商业化程度和使用行业

教育:针对学习机T20Pro/T20发布了AI新功能,包括AI中英文作文批改、英语AI口语对话、初中数学AI同步精准学等功能;办公:智能办公本X2、智能录音笔(SR702)、讯飞听见、智能麦克风M2将具备会议纪要能力、语篇规整能力、一键成稿能力三大新功能;AI虚拟人:通过多模态、全双工、自然交互,实现行业领域服务咨询、业务办理等功能,让星火全面提升“AI虚拟人”业务能力。

6.腾讯-混元

(1)模型简述

腾讯混元(HunYuan)大模型依托腾讯自研的太极机器学习平台构建而成。在模型层,混元大模型完整覆盖NLP大模型、CV大模型、多模态大模型、文生图大模型及众多行业/领域/任务模型。其中,HunYuan-NLP1T是国内首个低成本、可直接落地应用的NLP万亿大模型,其模型能力在自然语言理解任务榜单CLUE中登顶。在产业化应用上,混元大模型支持腾讯广告、搜索、推荐、游戏、社交等多个互联网业务生态的赋能和升级,实现技术复用和业务降本增效。

(2)商业化程度和使用行业

混元大模型已在腾讯多个核心业务场景落地,并带来了显著的效果提升。大模型支持了微信、QQ、游戏、腾讯广告、腾讯云等众多产品和业务,尤其是在广告内容理解、行业特征挖掘、文案创意生成等方面表现出色。例如,腾讯打造了以混元大模型为技术底座的广告多媒体AI技术矩阵。在广告投放中,相比以前的小模型算法,腾讯广告精排大模型当时累计给广告主带来15%的成交总额GMW(Gross Merchandise Volume)的提升。

7.商汤-日日新

(1)模型简述

2023年4月,商汤科技在技术交流会中正式发布“日日新SenseNova”大模型体系,实现CV、NLP、多模态等大模型的全面布局,并展示了问答、代码生成、2D/3D数字人生成、3D场景/物体生成等AI模型应用能力。

(2)具体功能

1800亿参数“商量”大模型赋能专业知识、代码生成、医疗等垂直场景。商汤于技术交流会同时发布1800亿参数“商量”(SenseChat)语言大模型,主要能力包括:1)长文本理解:相比ChatGPT,SenseChat支持财务、法务等专业领域超长文本知识理解,能够基于用户上传的长文本PDF文件进行理解和对话;2)代码生成:Visual Studio Code接入SenseChat插件,根据用户指令直接生成代码,在humaneval测试集上一次通过率为40.2%。据商汤表示,该数据高于Copilot;3)赋能行业:已落地新华医院“便捷就医服务”,辅助初步问诊、就医挂号建议等。此外,公司计划推出面向行业客户的类ChatGPT对话机器人服务。

(3)商业化程度和使用行业

商汤日日新大模型开放API体系包含自然语言生成API、图片生成API、视觉通用感知任务API和标注API。此外,商汤科技还提供数据标注、模型训练及微调等一系列MaaS服务,涉及创作设计、数字内容生成、医疗服务等相关行业。

8.百川智能

(1)模型简述

Baichuan-7B是由百川智能开发的一个开源可商用的大规模预训练模型。基于Transformer结构,在大约1.2万亿tokens上训练的70亿参数模型支持中英双语,上下文窗口长度为4096。Baichuan-7B在C-Eval、AGIEva和Gaokao三个最具影响力的中文评估基准进行了综合评估,并且均获得优异成绩,它已经成为同等参数规模下中文表现最优秀的原生预训练模型。

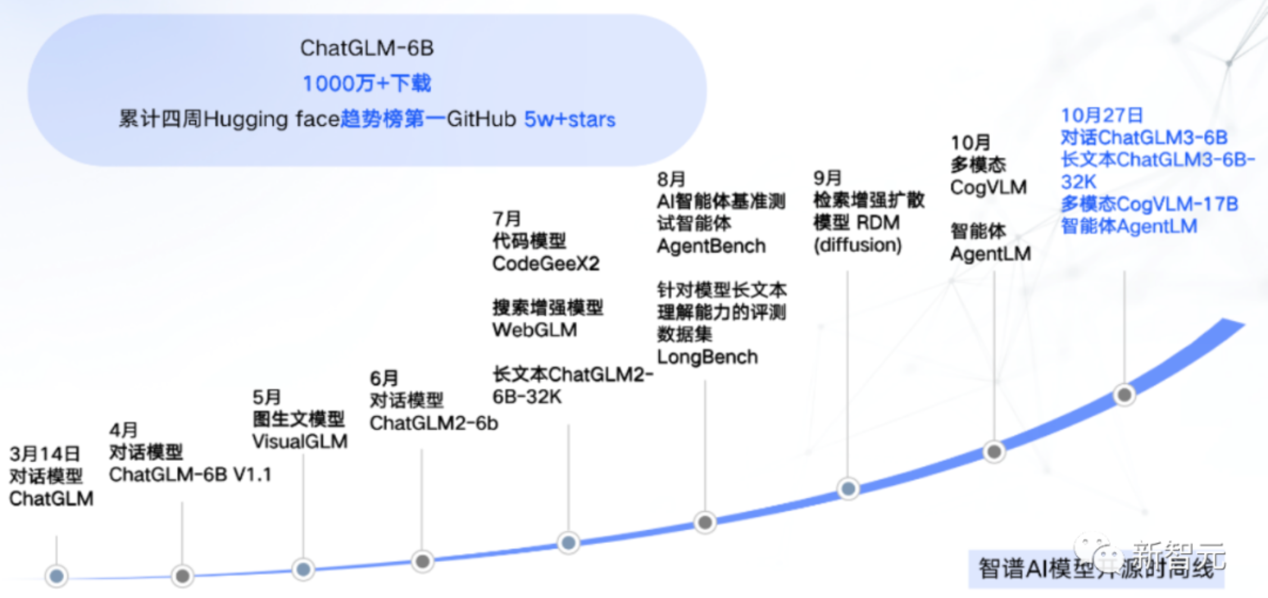

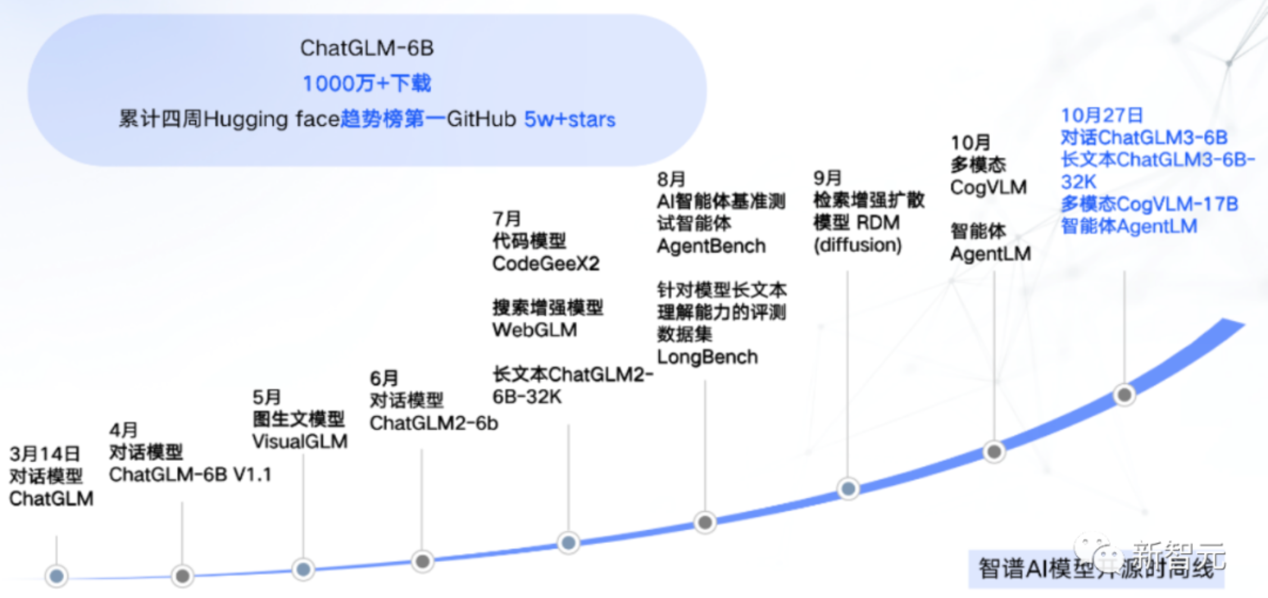

9.智谱AI

(1)模型简述

类ChatGPT对话模型ChatGLM-6B于2023年3月开源发布,可在消费级显卡上进行本地部署。ChatGLM-6B具有63亿参数,针对中文问答和对话进行了优化,在1T参数量的语料训练和监督微调、反馈自助、人类反馈强化学习等技术的加持下,ChatGLM-6B能生成相当符合人类偏好的回答。结合模型量化技术,用户可以在消费级的显卡上进行本地部署。不过,由于ChatGLM-6B规模较小,目前测试发现具有较多的局限性,如事实性/数学逻辑错误、可能生成有害/有偏见内容、较弱的上下文能力等。VisualGLM-6B是国内首个能理解图像的中文开源对话模型。2023年5月,智谱AI和清华大学KEG实验室开源了支持图像、中文和英文的多模态对话模型VisualGLM-6B,其语言模型基于ChatGLM-6B。图像部分通过训练BLIP2-Qformer构建起视觉模型与语言模型的桥梁。该模型在长视觉问答数据上进行了训练,能够生成符合人类偏好的答案。同时,结合模型量化技术,用户最低只需8.7G的显存就可以进行本地部署。此外,当前基于1300亿参数GLM-130B的ChatGLM模型正在内测开发中。ChatGLM -130B于2022年8月发布并开源,模型的部分性能优于GPT-3。

图27 智谱AI模型开源时间线

(2)具体功能

语言大模型:逻辑推理、内容创作、代码生成、信息提取;

(3)运行效率

2022年11月,斯坦福大学大模型中心开展了对全球30个主流大模型的全方位评测,GLM-130B是亚洲唯一入选的大模型。评测报告显示:GLM-130B在准确性和公平性指标上与GPT-3接近或持平,鲁棒性、校准误差和无偏性均优于GPT-3 175B。此外,模型仅需4张英伟达RTX3090就可以运行。

10.MiniMax

(1)模型简述

MiniMax是国内首家多模态AI大模型创业公司。公司成立于2021年,致力于成为通用人工智能时代基础设施建设者和内容应用创造者。公司自研了整套端到端AGI引擎系统:底层基础设施以极高效的并行计算能力支撑超大规模跨模型训练任务;据介绍,文本、语音、视觉三个模态大模型算法能力均达到世界级领先水平;计算平台为通用模型提供推理优化能力,极大降低AIGC产品研发门槛。公司首款C端产品Glow定位AI虚拟聊天社交软件,主打聊天、陪伴等情感功能。目前,MiniMax仅对企业开放API申请。

(2)具体功能

文本大模型拥有总结说明、内容创作、人设对话、代码生成四大功能;语音大模型拥有有声读物、数字人、新闻资讯、游戏角色四大应用场景。

11.Microsoft Copilot

(1)模型简述

自2023年3月17日,微软公司宣布GPT-4会登陆Office全家桶以来,Microsoft 365 Copilot就备受用户期待。2023年在9月21日,微软公司宣布AI Copilot于9月26日在Windows系统铺开,定位为“日常AI伴侣”。Microsoft 365 Copilot企业版于11月1日全面上市,AI将进入Word、Excel、PowerPoint、Outlook和Teams等协同工具来提高工作效率。微软公司同时宣布Bing搜索引擎和Edge浏览器的AI新功能,依托于微软重金支持的OpenAI公司最新发布的DALL.E大语言模型,可根据用户的搜索历史记录提供更具有个性化的回复、新的AI驱动购物体验,以及更具移动化和可视化的Bing Chat Experience智能聊天功能。

(2)具体功能

Copilot功能具有四项功能:生成任务计划、风险评估、项目状态报告、类似于聊天的交互式体验,可以极大地提高使用微软办公软件的效率。

12.Stability AI

(1)模型简述

Stability AI是Stable Diffusion(流行的文本到图像模型)背后的创业公司。2023年5月13日,Stability AI推出Stable Animation SDK,和此前爆火的Stable Diffusion模型类似,可以基于文本生成3D模型。2023年7月27日消息,Stability AI宣布推出Stable Diffusion XL首个正式版1.0。该公司其产品主要包括图像生成模型Stable Diffusion、人工智能生成音乐的产品Stable Audio、AI编程工具Stable Code等多种产品。2023年4月18日,该企业以69亿人民币的企业估值入选《2023·胡润全球独角兽榜》。

13.快手-KwaiYii-66B

(1)模型简述

快手快意大模型(KwaiYii)是由快手AI团队从零到一独立自主研发的一系列大规模语言模型,当前包含了多种参数规模的模型,并覆盖预训练模型(KwaiYii-Base)、对话模型(KwaiYii-Chat)。快手AI团队将持续迭代快意大模型,一方面将继续优化模型性能并研发多模态能力,另一方面也在推进更多C端与B端业务场景下的落地。

14.中科闻歌YAYI

(1)模型简述

中科闻歌雅意(YAYI)大模型旨在为客户快速构建安全可靠的专属领域大模型应用,具备从海量数据和大规模知识中理解、学习和生成的能力,支持实时在线联网、离线私有部署、企业知识库问答和领域深度分析。主要包块YAYI-7B(70亿参数,100W领域指令数据)、YAYI-13B(130亿参数,150W领域指令数据)、YAYI-30B(300亿参数,200W领域指令数据)、YAYI-70B(700亿参数,1000W领域指令数据)四个大模型。

(四)应用层

我们将对国内外现有产品进行功能和优缺点的分析,并与传统方法做对比。

1.合成数据

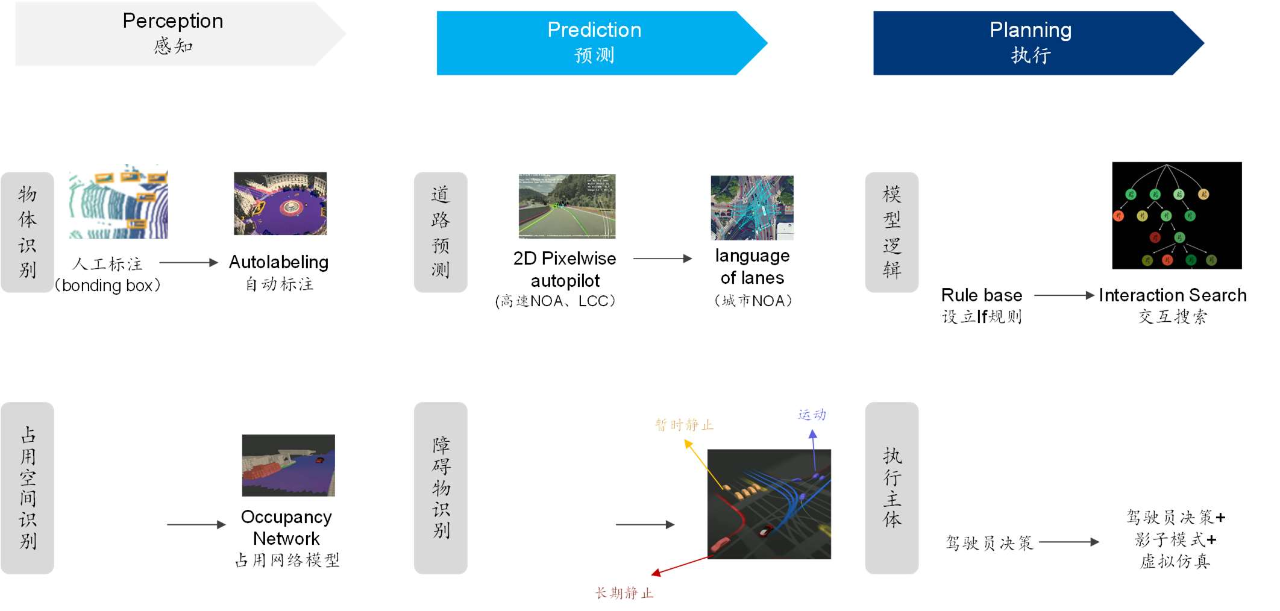

(1)自动驾驶

1)现有产品和功能

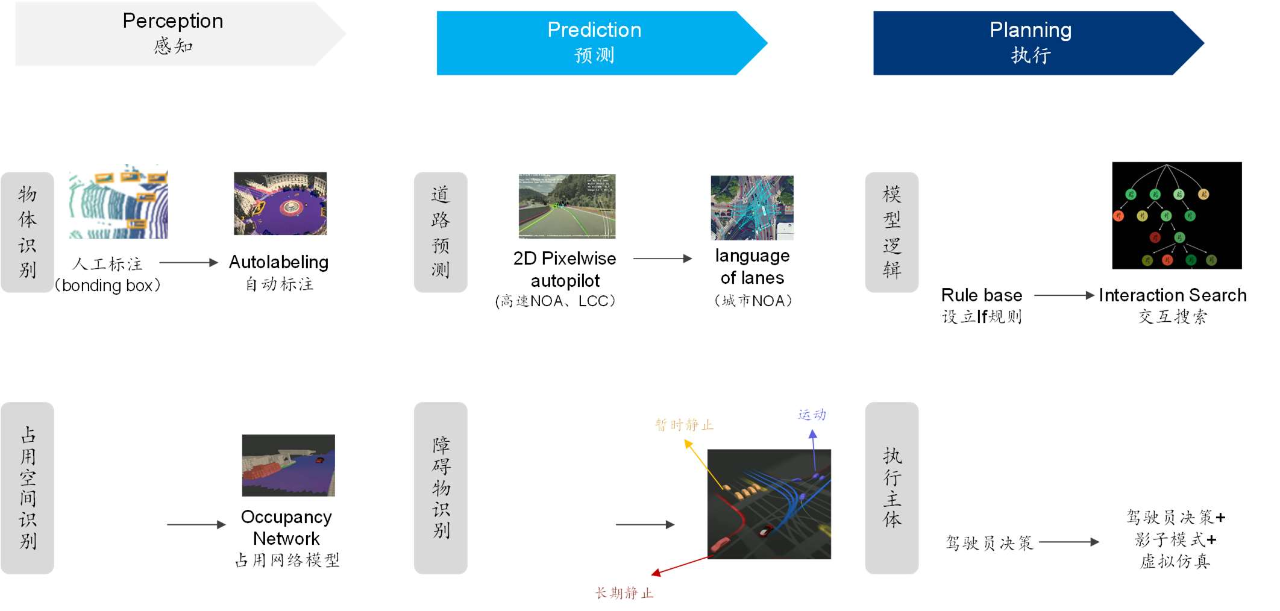

图28 自动驾驶决策执行三阶段在感知领域, 2022年及之前的行业总体商业化应用主要为2D+CNN算法。随着ChatGPT等AI大模型的兴起,感知算法已经升级至BEV(Bird’s eye view)+Transformer。目前,特斯拉(2021年)、小鹏+华为+理想等(2023年)已切换至BEV+Transformer。大模型赋能感知端算法能显著降低数据标注成本,提升感知预测执行全流程能力。

2)优缺点分析

Transformer算法更适用于自动驾驶大数据场景,同时具备较高的鲁棒性(可缓解一定程度的系统+网络风险)+较强的泛化能力(一定程度上缓解“长尾问题”比如恶劣天气下的模型不稳定性),具备更稳定+更准确的感知输出信息。以特斯拉FSD为例,进行物体识别时,自动标注将大幅降低系统成本。FSD通过自动标注优化系统效率,通过“多重轨迹重建”技术自动标注车辆行驶轨迹。目前在集群中运行12小时即可完成10,000次行驶轨迹标注,取代500万小时人工标注。通过机器的自我训练,减少了人力标注成本高、效率低的问题。自动标注技术成熟,人工标注团队规模缩小。2021年,人工标注团队为1000多人,2022年该团队裁员200余人。

3)发展趋势

大模型在高阶智能驾驶的应用已成趋势,因为其符合高阶智能驾驶数据规模增加+模型精度呈指数型增加的算法升级需求。预计未来会向感知决策一体化的智能驾驶通用大模型UniAD(Unified Autonomous Driving,自动驾驶通用算法框架)+全栈Transformer发展。具体来说,(A)在车端:大模型主要应用于合并检测不同任务小模型、物体检测和车道拓扑预测等;(B)在云端:大模型主要应用在数据自动标注、数据挖掘、小模型训练、自动驾驶场景重建等方面。从自动驾驶算法+算力+数据的框架来看,未来会对数据存储和传输、网络架构搭建、模型训练效率等方面提出更高的技术要求。

(2)金融科技

1)现有产品和功能

BloombergGPT是2023年3月彭博社发布的金融垂直领域大型语言模型,其具有500亿参数,在保证大语言模型通用性能的基础上,更加聚焦金融场景,更加适应金融术语的复杂性与独特性,有效实现“GPT+垂直知识”的深度融合。BloombergGPT模型在与同等参数量级模型的对比中表现亮眼:在金融专业任务的表现排第一,远超类似规模的开放模型;同时在一般任务的表现也达到甚至超过了平均水平。BloombergGPT将帮助彭博改进现有的金融NLP任务,如市场情绪分析、命名实体识别、新闻分类和问题回答等。

2)优缺点分析

以一个特定场景举例:“X公司裁员一万人”,这则信息在一般意义上描绘了负面情绪,但有时这会被认为是对公司的金融情绪的积极表现,可能会使得股票价格或投资者信心增加。经过垂直领域知识库专门训练的BloombergGPT能更好地应对金融行业的问题。

3)发展趋势

金融行业数字化程度领先,拥有数据富矿,是AI大模型率先落地的垂直领域之一。生成式AI的主要落地场景包括应用于各金融子行业的智能客服以及内容生成,例如投研领域的研报生成、投顾领域的投资建议生成、保险/资管领域的合同模板生成等等。BloombergGPT开启了垂直场景人工智能新的范式探索,其任务表现结果也证明了垂类大模型的价值。未来产业将会是通用基础大模型与垂直模型并存的格局形态。

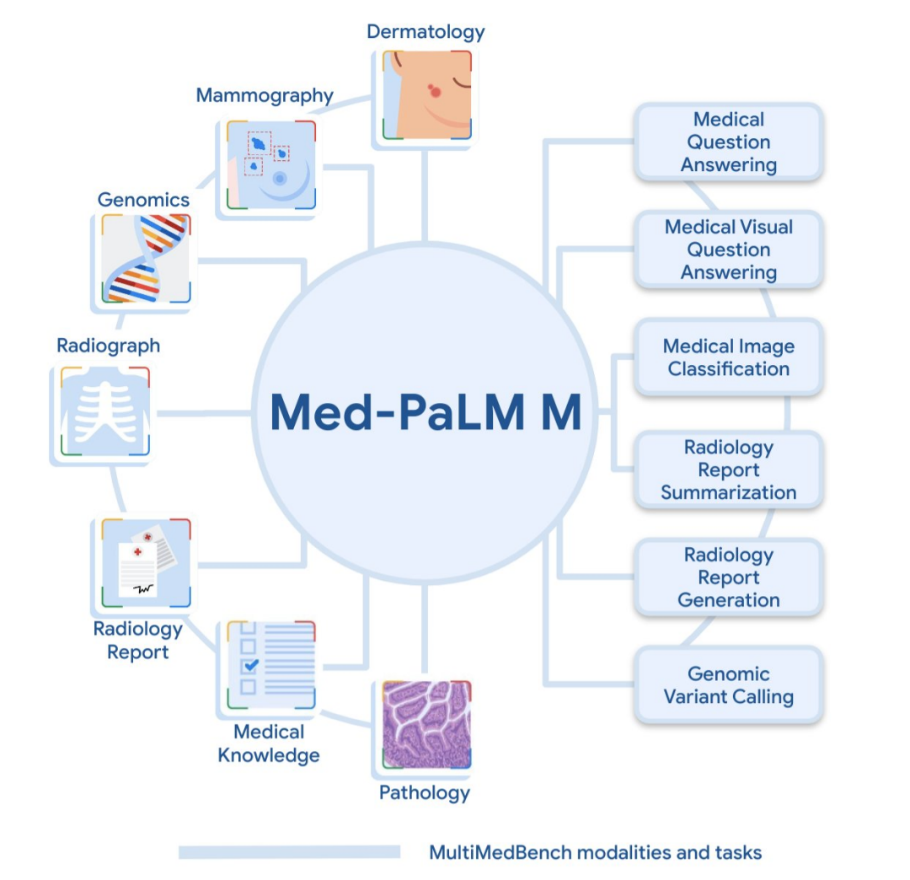

(3)医疗医药

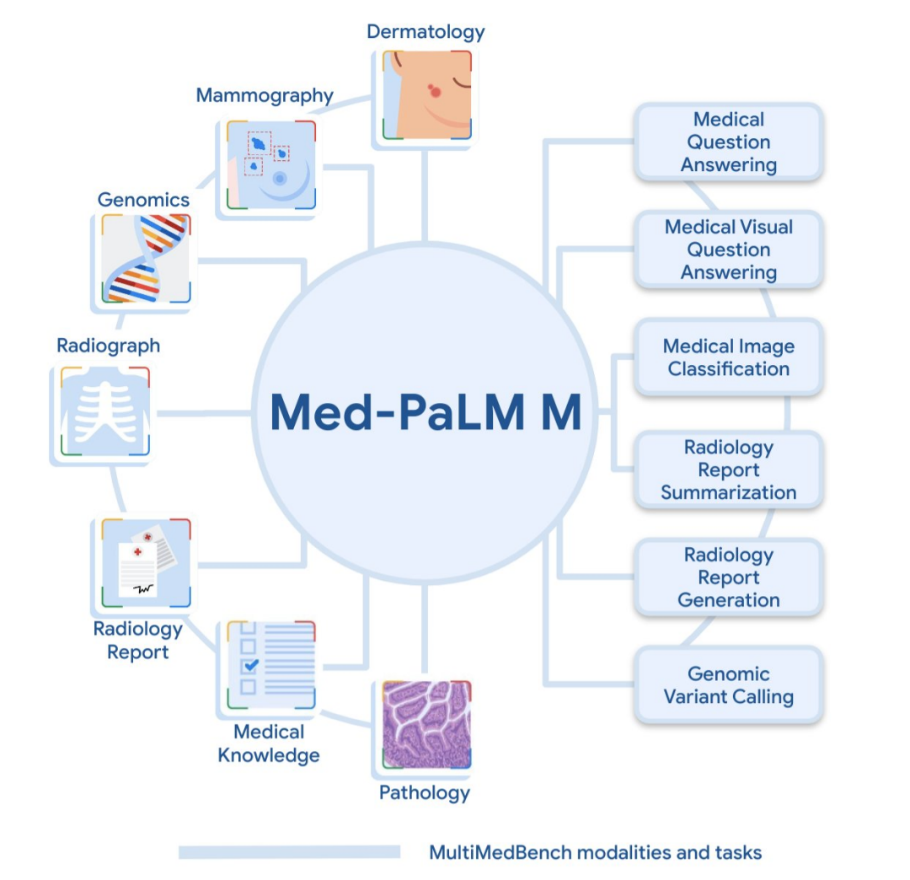

1)AI医疗问答 Google Med-PaLM

Med-PaLM 2是谷歌公司在2023年5月发布的一个医疗问答语言模型,应用于实时病例生成、医疗影响分析等领域,具有提高问诊效率、降低数据分析的人工成本等作用,例如:通过给Med-PaLM 2输入一幅X光片,它会自动根据输入信息来对患者的病情进行分析和诊断。Med-PaLM 2基于谷歌公司当下最先进的大语言模型PaLM2,在1000多个实际医疗场景问答中,Med-PaLM 2在9项基准测试中,有8项表现良好,相较于人类医生回答更受认可。和普通医生的回答相比,Med-PaLM 2有72.9%的回答被认为和医生回答相对一致。2023年7月,谷歌公司又发布了最新的Med-PaLM M,它是一种大型多模态生成式模型,可灵活编码和解释涵盖临床语言、医学成像、基因组学等的生物医学数据。Med-PaLM M在仅仅接收过语言的说明和提示下(未接收过病例图像表现),就能够在胸部X射线图片中准确识别和描述结核病。

图29 Med-PaLM M模型与任务描述(谷歌官网)

2)AI新药开发:根据功能需求设计/优化蛋白质,加速新药探索速度

DeepMind推出的AlphaFold和AlphaFold2实现了蛋白质空间结构预测的重大突破,推动行业快速发展。Salesforce Research、Tierra Biosciences和加州大学研究团队发布的蛋白质语言模型ProGen,能够在数百万个原始蛋白质序列上训练,可生成跨多个家族和功能的人造蛋白质。与AlphaFold2不同,ProGen这样的生成式AI能够生成自然界不存在的人工蛋白质序列。在国内,晶泰科技的AI药物发现平台ID4Idea能够根据不同需求策略实现定制化分子生成。

(4)智能制造

1)智能工业装备:融合智能算法的机器人、AGV(自动导向机器人)、机床等工业生产制造设备

目前,生成式人工智能主要通过两个层面对工业机器人进行辅助。第一,ChatGPT作为预训练语言模型,可以被应用于人类与机器的自然语言交互。机器通过ChatGPT理解人类的自然语言指令,并根据指令进行相应的动作;第二,GPT可以帮助机器在执行路径规划、物体识别等任务时做出相应的决策。国外方面,西门子将ChatGPT技术与其现有的自然语言技术相结合,通过将生成式AI嵌入智能交互系统的架构中,有效实现了操作者与系统自然语言的交互,目前其自动化生产SIMATIC IT软件已经引入ChatGPT;国内方面,2022年底百度联合TCL搭建文心电子制造行业模型,可以帮助TCL产线检测mAP指标平均提升10%以上;新产线的冷态起动效果可以提高至原来的3倍,产线投产的研发时间缩短了30%。

2)平台/工业软件与方案:各类具有AI能力的工业互联网平台及其衍生解决方案和应用服务(详见3.赋能工业软件)

例如,国内“AI+制造”解决方案供应创新奇智在2023年4月13日发布的“奇智孔明”,该产品针对制造业垂直场景的AIGC工程算法引擎,以工业预训练大模型为核心。奇智孔明拥有五大能力,分别是内容生成、智能问答、多轮对话、推理能力、代码生成,能够满足制造行业企业的个性化需求。模型将着重应用于制造业、工业软件领域,解决行业大客户专属需求,如交互式动态业务报表生成,智能产线设计等。

2.数字内容构建

(1)文本生成(Jasper AI)

1)现有产品和功能

Jasper AI是一个基于AI生成式大模型的文案创作工具,可以为用户提供超过60多个模板,帮助撰写广告文案、标语、网页文案、电子邮件、博客,以及社交媒体文章等不同场景的内容,并集成Grammarly工具来检查内容中涉及的抄袭和错误修复。Jasper AI底层的文案生成能力最早来自OpenAI公司提供的GPT-3基础模型,并结合营销内容文本(包括来自互联网的博客、论坛、网站、报纸媒体文本)进行微调训练。用户进入模板后只需要提供一些信息(如标题、产品基本信息描述、语气),就可以撰写营销文案等宣传内容。

图30 Jasper AI功能界面示意

2)优势分析

Jasper AI开辟了内容营销用例的深度,集成了SurferSEO、Grammarly、Copyscape等工具进行文章评分、语法/拼写检查、抄袭检查,简化了用户的工作流程;Jasper AI拥有数量庞大的用户社区。Jasper的Facebook社区有7万人,在社区中用户会分享“成功、技巧及有益建议以生成出色的营销文案”,使得社区用户能够在互动中获得更多的高价值建议和内容。

3)发展趋势

在ChatGPT发布后及其大模型的后续不断进化升级影响下,基于GPT-3发展的Jasper AI网站的访问流量在短短3个月内下降了近40%,ChatGPT的发布把很多浅度用户从Jasper这里吸走,Jasper在2023年7月宣布开始裁员。这种ToB端的模型应用给予我们一些风险启示:大模型领域发展如此之快,如果企业无法及时找到合适的定位或无法拥有足够的忠实用户粘性和吸引力,在技术积累不足的情况下容易陷入困境。这也给予我们关于内容生成或是数字内容构建商业模式的思考,即产品应该使用大模型还是小模型;是从零研发模型、微调现有模型,还是直接通过API接入现有大模型。

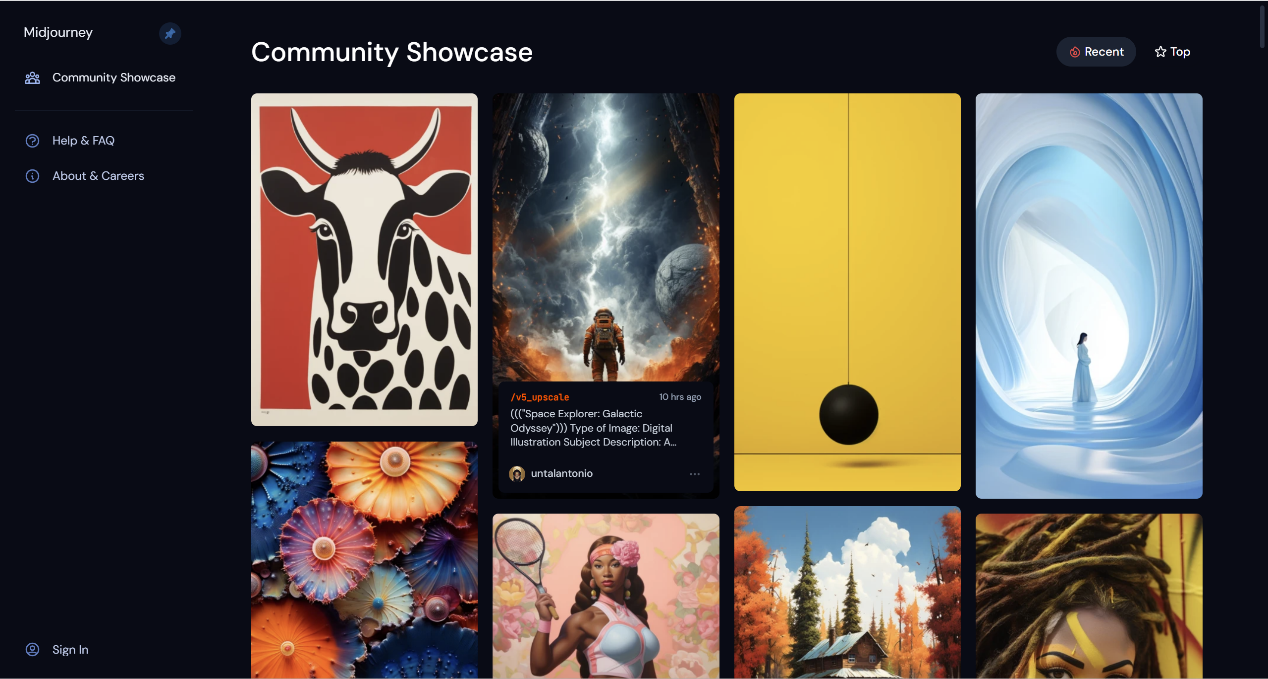

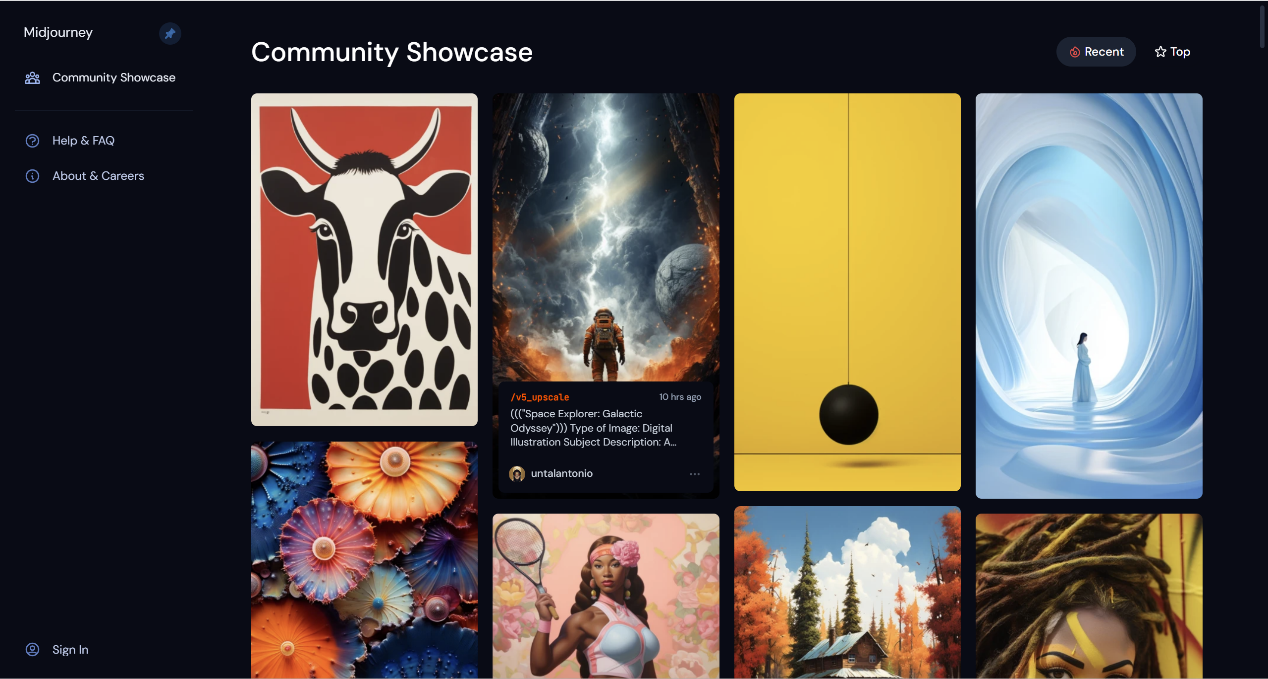

(2)图片生成(Midjourney)

1)现有产品和功能

图31 Midjourney生成作品Midjourney是一个AI生成图片工具,以Discord(一个游戏聊天应用与社区)为载体的社区交互设计,通过键入文字指令实现“文生图”及“图生图”。Midjourney Bot可直接与用户交互。登陆到Discord社区之后,在Midjourney服务器频道下方的输入框中可以输入prompt(文生图)或者图片链接(图生图),目前主要支持英文描述图片,点击Accept后会将请求加入工作队列,在高峰时段同时作图的人数较多时会在一分钟左右做出来。此外,用户也可以与Discord中的Midjourney Bot应用进行对话式交互,通过将Midjourney Bot加入server中即可在自己的频道中作图。截至2023年3月,Midjourney Discord频道拥有超1300万社区成员,是目前用户数最多的服务器,年营收约1亿美元。

2)优势分析

在模型端,Midjourney在参考CLIP及Diffusion开源模型的基础上抓取公开数据进行训练,从而构建自己的闭源模型;在数据端,以产品驱动型增长模式获得庞大用户量,通过数据飞轮和快速迭代建立竞争壁垒。由于开放社区成员均可对其他人所生成图片进行标注评级,因此Midjourney可以收集大量用户的反馈数据,并在此基础上不断迭代模型,以提供更好的用户体验。目前,Midjourney已迭代至V5版本,生成的图像具有更高的分辨率与解像度,光影效果和人物动作表情更自然丰富,更接近真实照片。此外,Midjourney V5还可以实现任意长宽比,可以实现自定义Prompt中的图像参照权重,能够容纳真实、抽象等更广泛风格的选择,图像解像度比上个版本提高2倍。Midjourney还推出了describe功能,通过自行闭环做到“图像反推prompt”,只需上传一张图片,系统便会自动分析图片并生成四条上传图片的主要特征“提示”,选择其中一个特征就可以据此创建新的图片。

3)发展趋势

从直接调用到“再训练”,关注数据标注与数据获取和生成:在垂直领域特性化数据不足的情况下,可以尝试直接调用大模型能力输出符合要求的、具有一定质量的垂直领域专业数据,用以扩充已有的有限数据集合,再经过专业标注整理形成特性化数据,将其再输入到模型中进行“再训练”,从而达到模型闭环迭代、自我优化的目的。

(3)音视频生成(GEN-2)

1)现有产品和功能

GEN-2是一个多模态生成视频模型,由Runway于2023年3月发布。GEN-2可以仅通过文字、图像或文字加图像的描述,在短时间内生成一个有关的视频。GEN-2是市场上第一个公开可用的文本到视频模型,并且能够真实一致的将图像或文本提示的构图和风格应用于视频生成。功能方面,GEN-2在延续GEN-1将图片或文本提示的构图和风格应用于原视频的功能上,实现了“直接生成视频”的功能,通过用户输入文字或图片,GEN-2可创建全新视频内容,且在风格、分辨率、贴合程度等方面都有较好表现。

图32 文字输入“纽约市公寓的窗户透过来的午后阳光”

图33 根据文字描述输出视频

图34 输入一张图片

图35 根据图片输出视频2023年7月24日,Runway宣布GEN-1和GEN-2可以开放使用,任何人都可以注册账号免费尝试。生成的视频长度为4秒,每秒消耗5个积分,利用免费额度可以生成二十六个视频。如果免费积分耗尽,付费标准为0.01美元/积分,即生成一个视频需要0.2美元。

2)优缺点分析

同样由Runway发布的Stable Diffusion(1.5版本)是知名的从文本到图像的潜在扩散模型,能够在短时间生成清晰度高、还原度佳的AI图片,无需预处理和后处理。GEN系列在扩展新功能的同时弥补了该扩散模型的缺陷。GEN-1可以提供相比之前方法更加逼真的生成效果,以及更加细粒度的语言控制,GEN-2在GEN-1基础上增加了生成视频功能,实现了文生视频领域的突破。目前,扩散模型仍然存在一些缺陷。例如,对于用户输入的内容编辑和结构之间的分离不够彻底,导致模型在处理这两方面时存在冲突;现有生成视频的方法需要对每个输入进行复杂的从头训练,训练代价较大。

3)发展趋势

GEN-2未来有望为视频内容行业发展全面赋能。移动互联网的繁荣催生了各类社交和流媒体平台,人们对其内容的需求旺盛,铸造了规模庞大的泛内容产业。在创意与效率这两大核心方面,AI技术全方位辅助内容创作领域:A)提升视频制作效率并降低制作成本,GEN-2直接通过文本或图片生成视频,可以降低拍摄或搜集视频素材的成本;B)增加丰富度创意,GEN-2模型可以遍历学习各种创意和风格,通过各类素材喂养,GEN-2可以创作出多种风格融合作品,补充人类创意;C)增加内容产业价值,对视频内容领域进行革新,为行业带来新的应用领域与新工种。AI视频生成模型未来更广泛应用于多个场景。A)与影视行业结合,提供专属的高效创作模块,比如特效、运镜、转场等模块化工具;B)在营销领域,可辅助设计者生产营销素材,实现个性化内容营销或批量化营销内容生产,实现降本增效;C)与游戏行业结合,游戏视频内容开发可以借助GEN-2生成视频来提高创意与效率,降低开发成本。

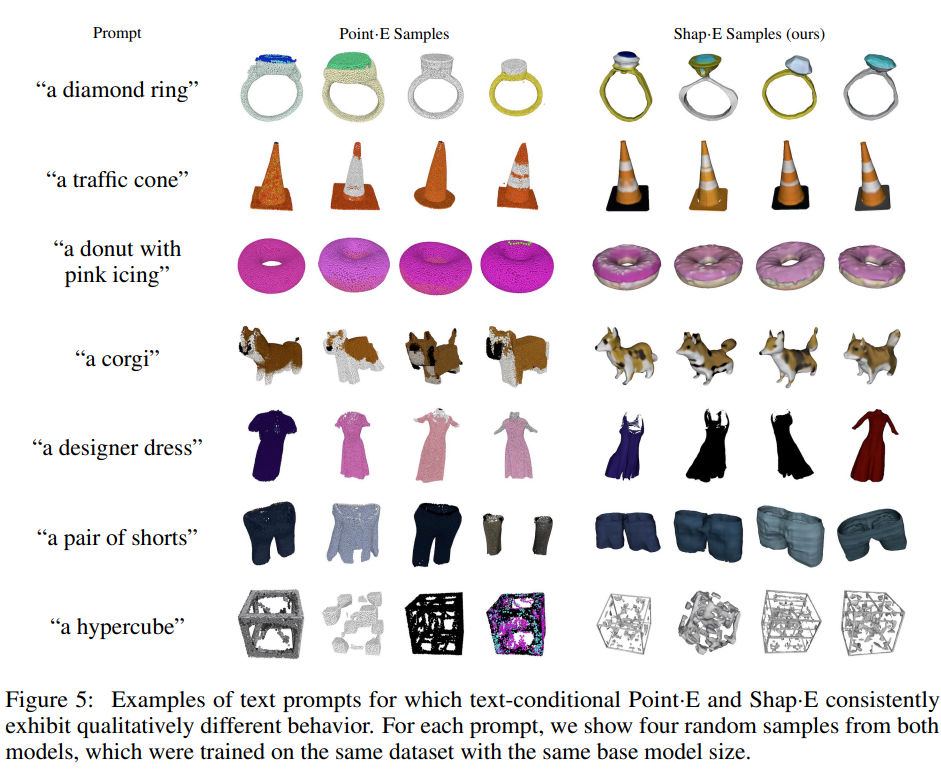

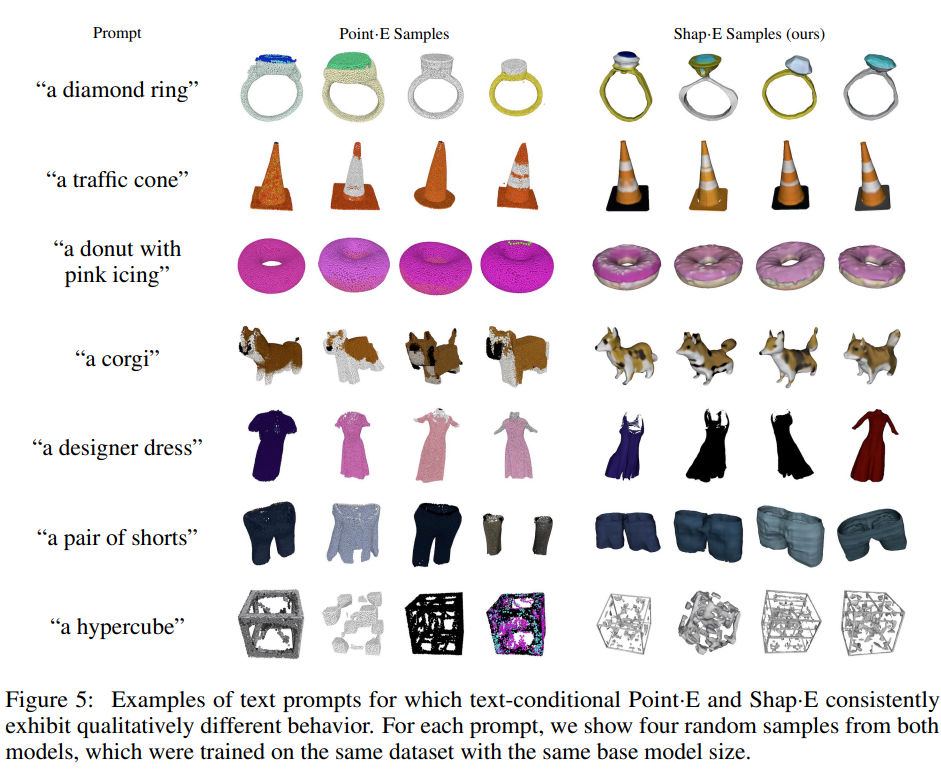

(4)三维模型生成(Point-E、Shap-E)

目前,三维模型生成的思路有两种,一是“2D升维派”,生成2D图像通过各种方式转换为3D模型,二是“原生3D派”,直接生成3D模型(建模+贴图)。第一种方法具有代表性的是OpenAI公司的Point-E模型;第二种方法还需要解决如何将3D数据集无损地输入模型中的问题,具有代表性的是NVIDIA Picasso平台(未开放访问),支持文字到3D图像生成。

1)现有产品和功能

Point-E是OpenAI公司在2022年12月发布的一个3D模型生成器,由文本图像转化模型(text-to-image model)、图像转化3D模型(image-to-3D model)和网格(mesh)转换模型组成,在对模型进行几百万3D数据集的训练之后,Point-E可以产生与文本提示匹配的彩色点云,可以用来通过3D打印制造现实世界的物体,而通过网格转换模型生成的mesh也可以为游戏和动画开发工作提供帮助。Shap-E是OpenAI公司在2023年5月发布的升级模型[24],相比基于点云的显式生成模型Point-E,Shap-E直接生成隐函数的参数来渲染纹理网格和神经辐射场,生成速度更快,建模质量更高。

图36 Point-E与Shap-E生成模型对比[24]

2)优缺点分析

Point-E模型只需几秒钟即可根据文本生成3D资产,相比同时期竞品模型Dream Fusion提速大约600倍。而当下的普通3D建模流程通常需要花费几小时到几天时间,AI生成式3D建模将极大帮助开发者降本增效。Point-E也具有一些局限性,比如基于点云建模的精细度问题,以及理解文本到图像模型中的准确率不足,导致形状与文本提示不匹配。而Shap-E虽然可以理解许多具有简单属性的单个对象prompt,但它在组合概念方面的能力有限。该模型很难将多个属性绑定到不同的对象,并且当请求两个以上的对象时,无法有效生成正确的对象数量。

3)发展趋势

基于生成式AI的3D建模将助力游戏、影视、室内设计、建筑和各个科学领域内的建模工作,但也存在一些风险,例如,版权问题、模型继承训练数据偏差产生危险,以及基础模型快速迭代形成技术超越等。

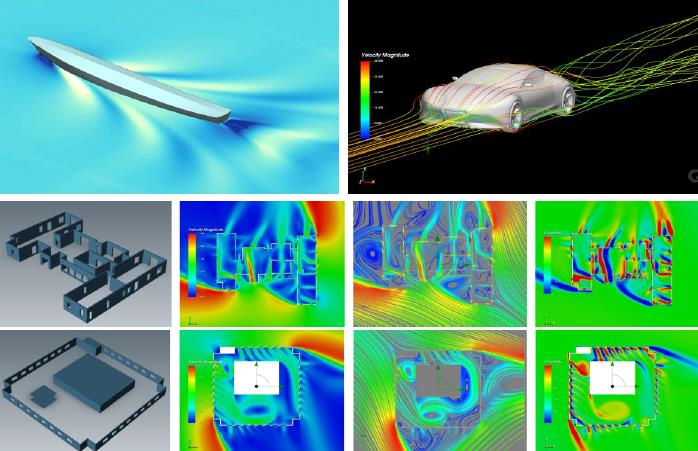

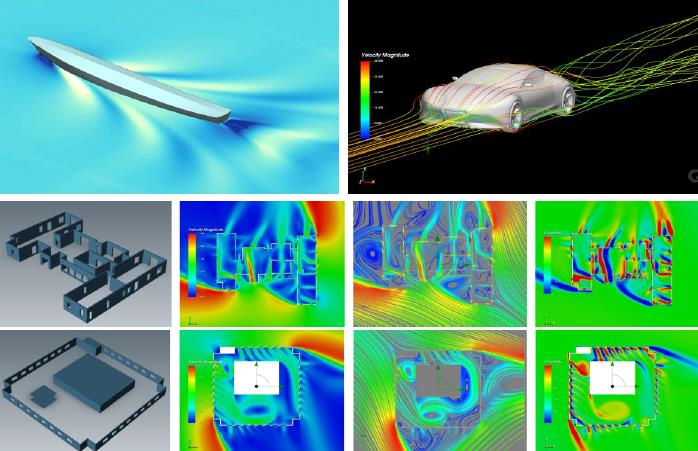

3.赋能工业软件

工业软件是服务企业“规划、研发、生产、销售、服务”全流程的产品,本质是将工业知识软件化,将企业在产品的规划、研发等全流程中的经验沉淀融合在软件系统中,以提升企业的工作效率。工业仿真软件属于研发设计类软件,是工业软件的“皇冠”,是制造业的大脑神经。工业仿真软件即通过数学、物理等多学科知识,运用其机理和演化规律,精细模拟各类物理现象;通过计算分析,对未来进行预测,为创造创新和制定决策提供依据。工业仿真软件广泛应用于航空航天、船舶与海洋工程、汽车、机械、环境、能源等领域,是开展高端装备研发、性能预测与优化设计的最重要的工具软件。

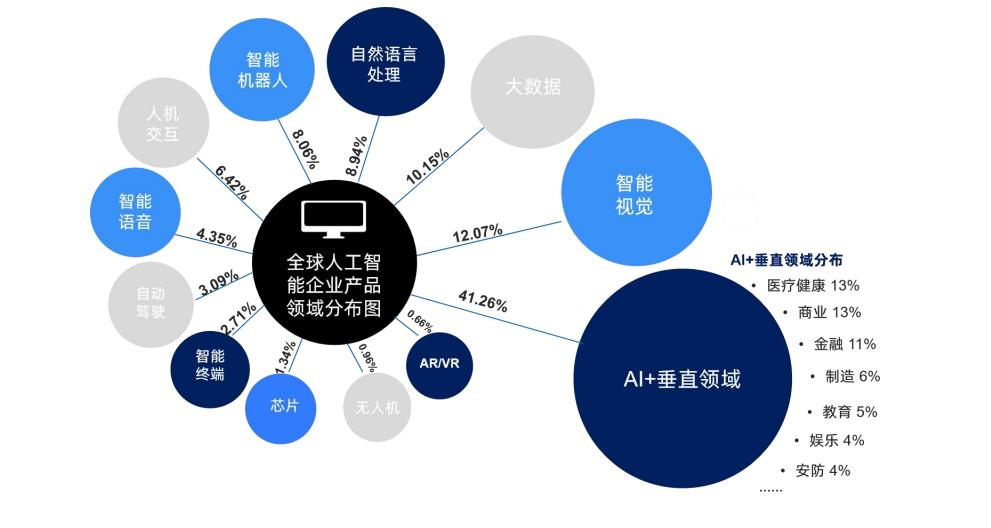

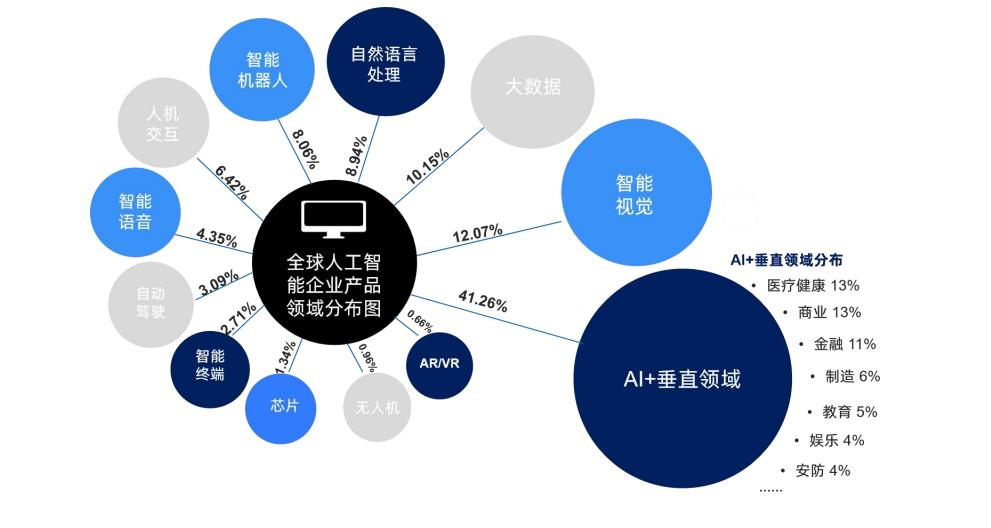

图37 AI应用场景分布从全球应用场景看,AI更多地应用于金融、服务等行业,在制造业中的应用比例较低。具体来说,AI可以在以下方面赋能工业仿真软件:

图38 复杂湍流模型示意图计算效率是仿真技术大规模推广的另一大难点,除了依靠硬件设备的算力提升之外,AI算法应用可为计算效率带来质的变化。同时,AI在发现新算法、提升计算效率方面已有重大突破,可以进一步形成自我优化迭代的效率提升流程。数字孪生是综合运用感知、计算、建模、仿真等技术,通过软件定义,对物理空间进行描述、诊断、预测、决策。工业仿真可助力实现数字孪生的预测、决策功能,让数字孪生技术在实际应用中获得更大价值,而人工智能则可以助力仿真技术与数字孪生实现融合。

4.MaaS新模式

大模型具有固定成本高、通用性强的特点,MaaS企业依托已经训练好的大模型,向ToB客户提供包括API调用、模型训练、模型微调、模型部署等服务。然而,MaaS是否是一个经得起考验的商业模式呢?我们认为此商业模式下企业竞争壁垒有四方面:服务、数据、算法、算力:1)在服务端,既有OpenAI公司这样的主要通过大模型技术领先与迭代来吸引企业合作,也有像腾讯、百度等国内企业向客户提供专属的行业大模型精调定制方案;2)在数据端,垂直领域下的专业数据最先被直接进行业务接触的公司收集,而这些公司往往也会选择自己做起大模型微调或使用专业数据集自行训练的决策;3)在算法端,在大模型迭代速度如此之快、性能水平尚可的开源可商用模型,如Meta公司LLaMA2的围攻下,是否还有更多企业会投入巨大资金从零研发新的大模型?4)在算力端,云计算服务正在加快发展,这个壁垒可能会因为云计算规模化的成本下降而消解。综上所述,我们认为MaaS的赛道最终可能只有少量头部企业能够继续支撑。

三、AGI-Generative AI的现状与未来

(一)数据、算法、算力三要素

仔细观察Generative AI产业链的纵横延伸,从大模型“数据-算法-算力”三要素来看,芯片层主导算力,架构层和模型层主导算法,数据既可以来源于各公开语料库或其他媒体数据库,也可以来源于各垂直领域公司所掌握的高质量标注的特性化数据。对于大模型相关领域巨头企业,算力需求可以通过大规模采购AI计算芯片,搭建训练服务器来解决。算法需求实质上对应着研发人才需求,可以通过组建相应部门、收并购AI初创企业来实现解决。企业本身所能触及到的各类数据资源则可以对应数据训练需求。AIGC时代巨头企业有能力自己搭建大模型以及背后的整套生态。对于大模型相关领域初创团队,算力需求在当前AI芯片市场整体供不应求的情况下往往对应着无法承担的巨额成本,此时可以转向寻求与超算中心、云计算服务企业等的合作,或是不一昧追求大参数量,在模型投入数据与输出性能比值上取得折中的更优水平。对于致力于AI赋能各垂直领域的企业,目前国外在各个垂直领域较为领先的明星产品与企业的发展历程和商业策略值得借鉴学习。具体来看,有“特性化数据+通用大模型”、“特性化数据+自研垂直领域模型”(或基于开源模型的针对性再优化)、针对垂直领域的完全自研模型等几条发展路径可供探索;有ToB实现降本增效、ToC开放订阅制收费,或是基于生成式人工智能优势,试图开辟全新市场赛道和商业模式等几种发展策略可供匹配。以AIGC为代表的通用人工智能的“iPhone时刻”已经到来。

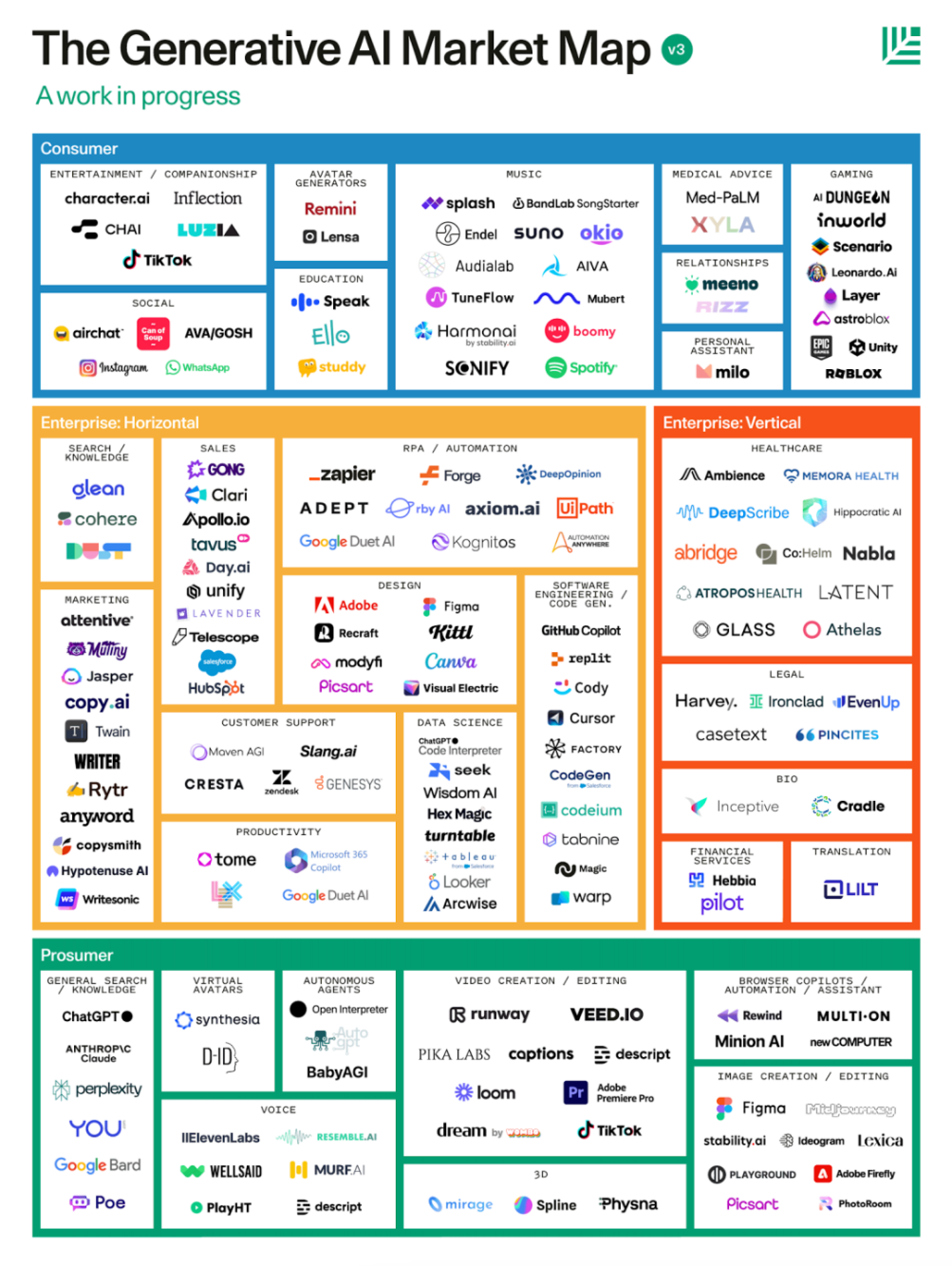

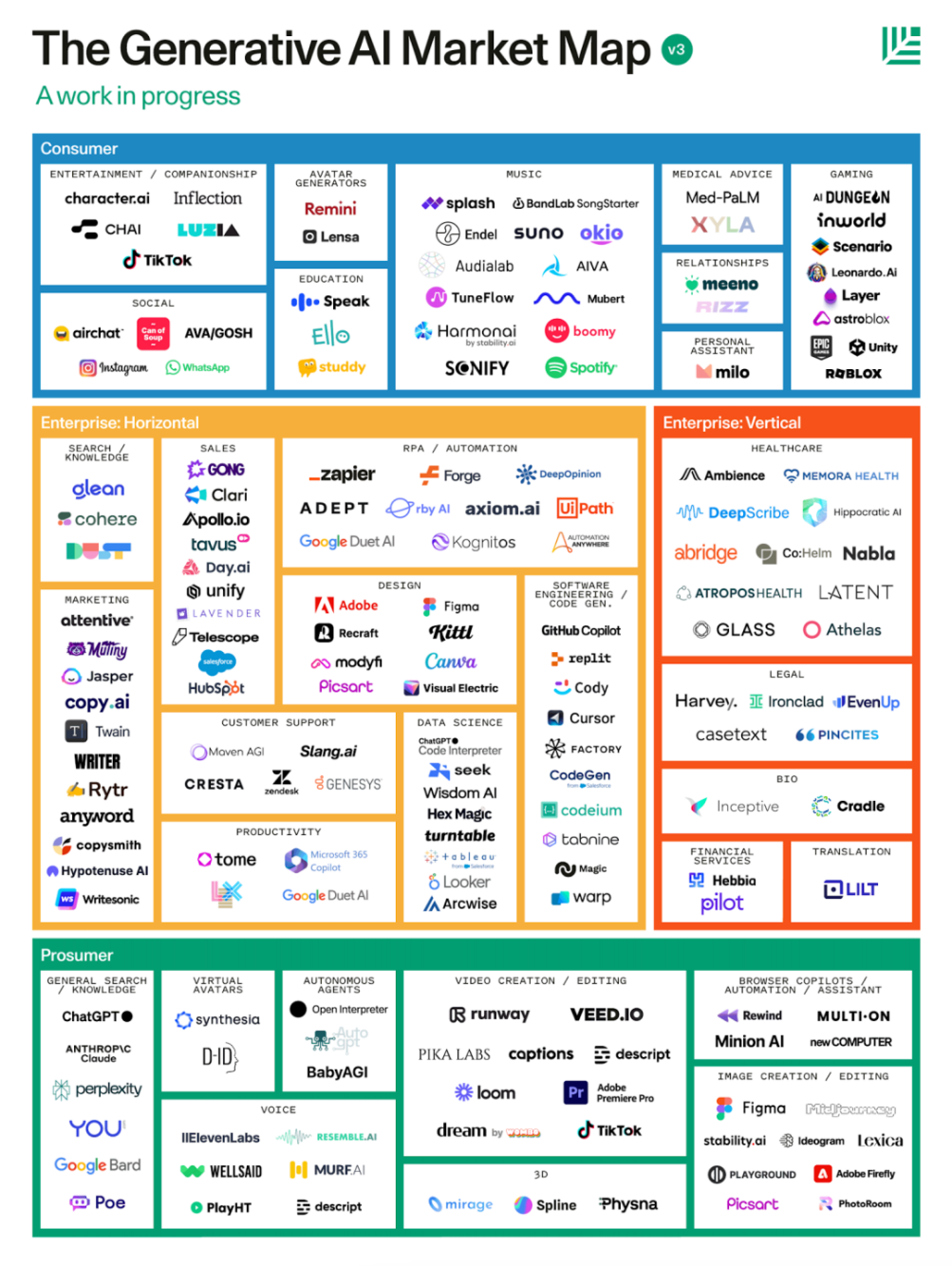

(二)市场表现

根据彭博智库的数据,2022年全球Generative AI市场整体收入为400亿美元,预计2027年及2032年将分别达到3990亿美元和1.3万亿美元;2022~2032年复合增长率高达42%。到2025年,Generative AI产生的数据将占所有生成数据的10%(2021年仅为1%)。ChatGPT的横空出世引发了资本市场对AI领域投资的新一轮热潮,全球领先的AIGC企业OpenAI公司凭借103亿美元(约人民币745亿元)的B+轮融资,一跃成为2023年上半年AIGC赛道获最大融资额的公司。2023年上半年,全球AIGC行业融资总额达1066.56亿元,融资次数共计78次。从全球融资规模来看,B轮及以后轮次(含战略投资)融资规模占比97.17%。其中,中国AIGC行业融资总额达62.39亿元,融资次数共计56次。上半年,全国获最高融资金额的企业为Minimax名之梦,融资金额达2.5亿美元(约人民币17.96亿元)。但是,资本市场的火热并未让AI如大家所设想的那样成为各行各业的加速器,这些成功的早期迹象并没有改变一个事实,那就是许多AI公司根本没有产品市场契合度,或可持续的竞争优势,而整个AI生态系统的繁荣是不可持续的。AIGC最初由惊艳全世界的技术打开了市场的大门,但应用尚处于天马行空的想象中(虽然有少量场景应用在加速落地过程中);而当AI的热度似乎有所消散的下半年,它才真正开始由“技术”转向“客户”,由“想象”落地“应用”,这将端到端地解决人类问题。这些应用与首批推出的应用在本质上有所不同。基础大模型逐渐不再过分的被“神化”,这些应用往往将基础模型作为更全面解决方案的一部分,而不是整个解决方案。它们引入了新的编辑界面,使工作流程更加粘性,输出效果更好,并且往往是多模态的。美国红杉资本制作的AIGC市场地图按照使用案例而非曾经的模型模态来分类,恰好体现了AIGC市场从技术开发到落地场景的逻辑变化与发展程度的变化。

图39 AIGC市场地图(红杉资本)

(三)中国AIGC行业现状

根据前瞻产业研究院的数据,2022年中国生成式AI市场规模约人民币660亿元,预计2020~2025年复合增速将达84%,到2025年将占全球市场规模(2,170亿美元)的13%。但在技术与应用层面,中国AIGC行业的发展仍存在一些制约条件。

1.算力硬件产能不足

由于无法获得高端GPU(图形处理器)芯片A100与H100,国内大模型研发机构在算力上遭遇瓶颈。为应对上述困境,中国本土芯片研发厂商加强科研,在算力技术上实现重要突破。目前,中国市场可获得的A800 GPU芯片,传输速度仅为顶尖产品A100的70%。由于AI技术发展高度依赖先进GPU,需借助芯片进行大量模型训练和扩展,部分国内科研机构和科技企业受到较大影响,尤其在目前大模型参数量快速膨胀、算力需求显著增加的情况下。

2.行业大模型或主导发展方向

通用大模型需要海量数据作训练用途,但中文网站数量从全球来看占比仅为1.4%(英文网站占比达54%),可用作训练的公开中文语料库(含文本、图片、视频等素材)往往数量有限、质量不均。与此同时,国内用户在网站和移动端APP产生的海量数据,基于保护用户隐私的原因,大部分也未能应用在大模型训练上,对模型训练的效率和精度都造成不利影响。因此,相较于适用于多领域、多任务的通用大模型,行业大模型更依赖于开发者对垂直场景的理解和海量行业数据支持。在算力受限的背景下,行业大模型更有可能成为中国AIGC厂商的制胜赛道。就行业大模型而言,国内市场正呈现差异化竞争格局:某头部互联网大厂的行业大模型根植于游戏、广告、内容创作等多媒体领域,成为提升广告和游戏场景创作效率的生产力工具;国内前三的超大规模云服务商开发的产业级知识增强大模型则凭借其对中文语言的强大理解能力,赋能汽车行业售后服务与知识库构建、医疗行业单据识别、社科行业版权保护与词条管理等。

3.应用场景集中于商业化发展成熟的优势产业

中国生成式AI企业利用国内垂直场景优势,将生成式AI优先应用于商业化基础设施较完善的新兴行业中;而欧美同行则利用当地成熟的SaaS市场,将生成式AI应用到高科技、通信及各种传统行业(如医疗、教育等),应用范围更加广泛。在国内,生成式AI应用发展最迅速的领域包括电商、传媒、娱乐和游戏,尤其是数字虚拟人和电商视频营销,而大部分传统行业(如金融、能源、教育等)仍处于小规模试点阶段。生成式AI应用得以在互联网电商平台蓬勃发展,原因在于中国拥有优质的电商和供应链生态以及庞大的消费者群体,为生成式AI应用落地提供了契机。典型的行业应用案例包括视频行业的某生成式AI的3D短视频内容厂商、电商行业的某领先生成式AI视频大模型研发企业,以及游戏行业的某互联网平台旗下的游戏与AI研究和应用机构等。上述企业中,生成式AI的3D短视频内容厂商能够基于文本生成3D视频内容,并通过抖音、快手、B站等短视频平台进行推广,极大提高了短视频内容生产者的创作效率。

(四)风险与政策

目前,Generative AI值得注意的风险挑战包括公平性受损、侵犯知识产权、信息泄露、恶意使用、安全威胁、模型幻觉及第三方风险等。其中,模型幻觉、侵犯知识产权、信息泄露三大风险值得重点关注。1)模型幻觉:所谓“幻觉”,指的是人工智能模型生成的内容,不是基于任何现实世界的数据,而是大模型自己想象的产物。以ChatGPT等为代表的大语言模型的“幻觉”,不仅会让人类在海量信息中难分真假,还会对用户的隐私安全、财产安全带来威胁;2)侵犯知识产权:生成式人工智能和基础模型通常利用基于互联网的数据,导致潜在的知识产权侵权事件(例如侵犯版权、抄袭);3)信息泄露:生成式人工智能可能会通过(可能无意的)使用用于模型训练的个人或其他敏感信息来加剧隐私问题,从而产生潜在的敏感结果。我国关于生成式人工智能的政策文件《生成式人工智能服务管理暂行办法》自2023年8月15日起施行。《办法》规则明确,提供和使用生成式人工智能服务需要坚持社会主义核心价值观,要求相关企业再提供服务前,向国家网信部门申报安全评估,并按照《互联网信息服务算法推荐管理规定》履行算法备案和变更,注销备案等手续;态度鲜明:国家坚持发展和安全并重、促进创新和依法治理相结合的原则,采取有效措施鼓励生成式人工智能创新发展,对生成式人工智能服务实行包容审慎和分类分级监管。我国生成式人工智能将在政策指导下健康有序发展。

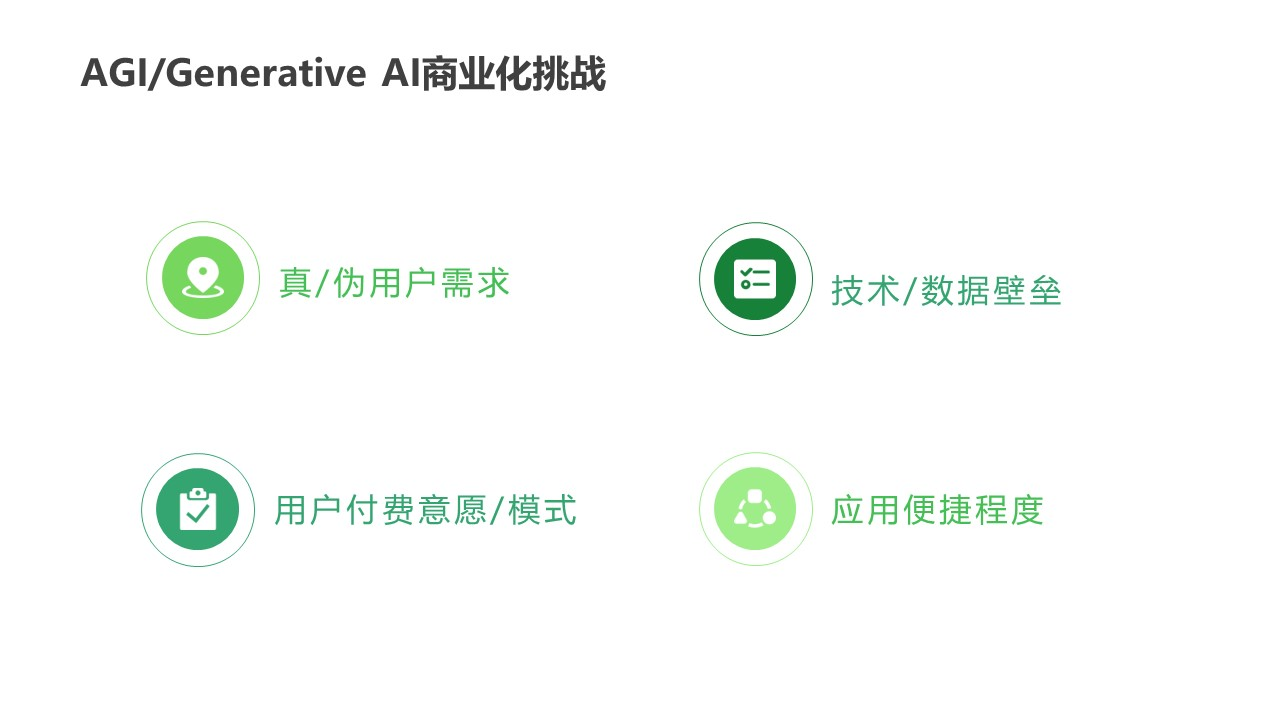

(五)商业化挑战与未来展望

我们认为,AGI/Generative AI商业化挑战与未来展望聚焦于以下四方面:真伪用户需求、技术/数据壁垒、用户付费意愿/模式、应用便捷程度。

图40 AGI/Generative AI商业化挑战生成式人工智能并不缺乏使用案例或客户需求。用户渴望AI能使他们的工作变得更容易,他们的工作产品变得更好。因此,ChatGPT成为历史上最快达成十亿用户量的APP,仅仅用时两个月。然而,所有AI类产品都面临用户留存困难的问题,即使是ChatGPT的首月留存率也不足60%,而大部分同类AI产品更是低于20%,相比于YOUTUBE的85%首月留存率,则明显后劲不足。

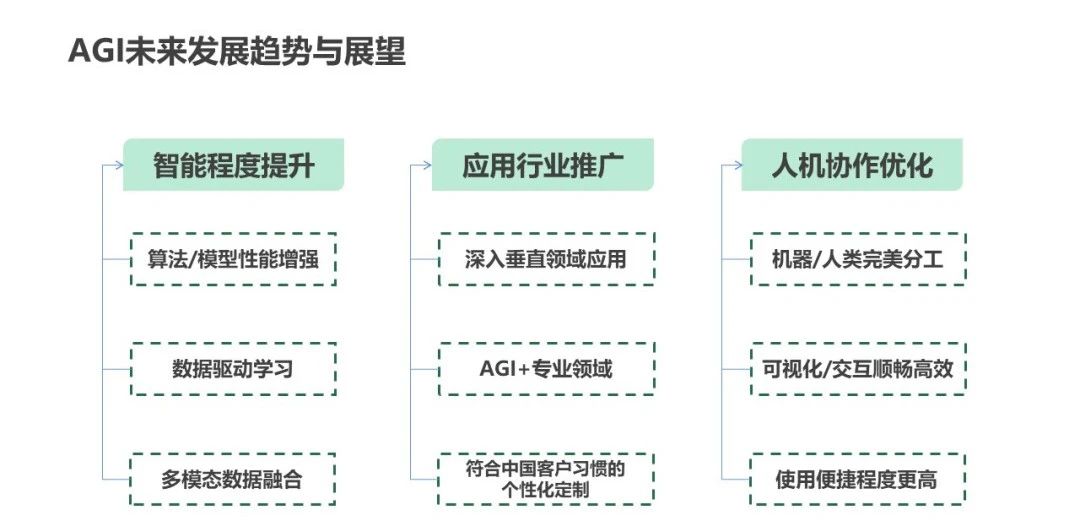

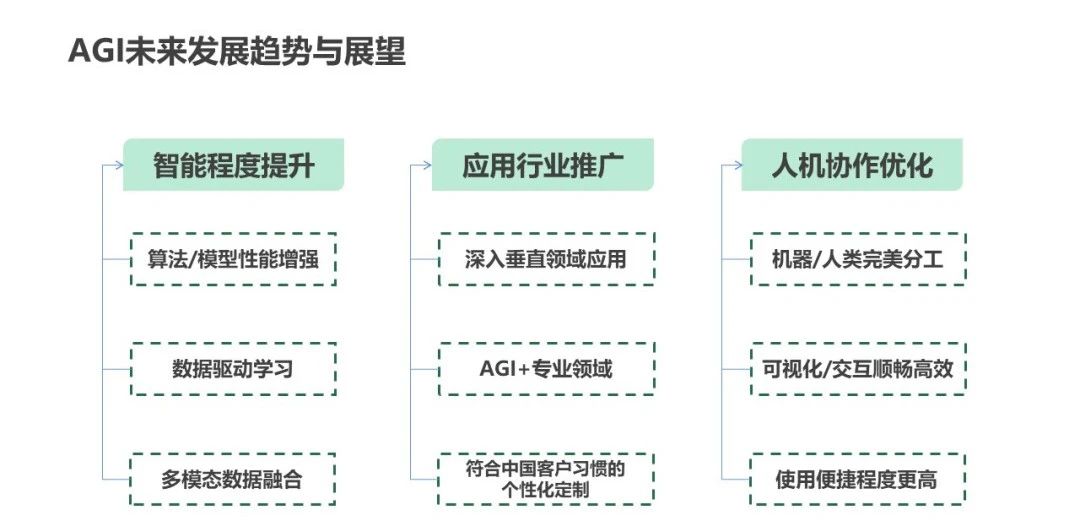

图41 AGI未来发展趋势与展望根据Amara法则——人们对于技术的影响和影响的判断往往存在偏差,人们倾向于在短期内高估一项技术的效果,在长期内低估其效果。AIGC正在由年初的过热状态逐渐降温,这并不代表AI是仅受资本追捧而只能昙花一现的过去式;相反,市场的理性回归正在帮助AIGC从“云端”落地,开发者们从技术的进步转向应用的拓展,从追逐通用大模型转向精雕行业大模型,最终或许能将一个个离散的行业大模型有机整合,形成“Society of Mind”,引领真正的AGI变革。

参考资料

[1]Jay Alammar.(August 12,2019).The Illustrated GPT-2 (Visualizing Transformer Language Models).http://jalammar.github.io/illustrated-gpt2/[2]Corby Rosset.(February 13,2020). Turing-NLG: A 17-billion-parameter language model by Microsoft.https://www.microsoft.com/en-us/research/blog/turing-nlg-a-17-billion-parameter-language-model-by-microsoft/[3]https://blog.csdn.net/rn0_46510245[4]Ali Alvi, Paresh Kharya.(October 11,2021).Using DeepSpeed and Megatron to Train Megatron-Turing NLG 530B, the World’s Largest and Most Powerful Generative Language Model.https://www.microsoft.com/en-us/research/blog/using-deepspeed-and-megatron-to-train-megatron-turing-nlg-530b-the-worlds-largest-and-most-powerful-generative-language-model/[5]Jack W. Rae.(21 Jan,2022).Scaling Language Models: Methods, Analysis & Insights from Training Gopher.arXiv:2112.11446 [cs.CL][6]Jordan Hoffmann.(29 Mar,2022).Training Compute-Optimal Large Language Models.arXiv:2203.15556 [cs.CL][7]Aakanksha Chowdhery.(5 Oct 2022).PaLM: Scaling Language Modeling with Pathways. arXiv:2204.02311 [cs.CL][8]Baolin Peng.(June 23, 2022).GODEL: Combining goal-oriented dialog with real-world conversations.https://www.microsoft.com/en-us/research/blog/godel-combining-goal-oriented-dialog-with-real-world-conversations/[9]Artnitolog Vasilev Ruslan.(Jan 25,2023).yandex/YaLM-100B.https://github.com/yandex/YaLM-100B[10]肉眼品世界.(2023-05-02).一网打尽!国内外大模型调研汇总https://blog.csdn.net/weixin_45727359/article/details/130460473?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522169165617416800222898654%2522%252C%2522scm%2522%253A%252220140713.130102334..%2522%257D&request_id=169165617416800222898654&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~all~sobaiduend~default-4-130460473-null-null.142%5ev92%5einsert_down1&utm_term=Jurassic-1&spm=1018.2226.3001.4187[11]Alec Radford.(26 Feb,2021).Learning Transferable Visual Models From Natural Language Supervision.arXiv:2103.00020 [cs.CV][12]Ze Liu.(25 Mar,2021).Swin Transformer: Hierarchical Vision Transformer using Shifted Windows.arXiv:2103.14030 [cs.CV][13]太阳花的小绿豆.(2021-11-03).Swin-Transformer网络结构详解.https://blog.csdn.net/qq_37541097/article/details/121119988?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522169173498616800185894817%2522%252C%2522scm%2522%253A%252220140713.130102334..%2522%257D&request_id=169173498616800185894817&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~all~top_positive~default-1-121119988-null-null.142^v92^insert_down1&utm_term=SWIN&spm=1018.2226.3001.4187[14]Hao Zhang.(11 Jul 2022).DINO: DETR with Improved DeNoising Anchor Boxes for End-to-End Object Detection.arXiv:2203.03605 [cs.CV][15]Xiaohua Zhai.( 8 Jun,2021).Scaling Vision Transformers.arXiv:2106.04560 [cs.CV][16]Olivia Wiles.( 21 Oct,2021).A Fine-Grained Analysis on Distribution Shift.arXiv:2110.11328 [cs.LG][17]Arnav Chavan.( 3 Jan,2022).Vision Transformer Slimming: Multi-Dimension Searching in Continuous Optimization Space.arXiv:2201.00814 [cs.CV][18]Alexander Kirillov.(5 Apr,2023).Segment Anything.arXiv:2304.02643 [cs.CV][19]Xinlong Wang.(6 Apr,2023).SegGPT: Segmenting Everything In Context.arXiv:2304.03284 [cs.CV][20]Maxime Oquab.(14 Apr,2023).DINOv2: Learning Robust Visual Features without Supervision.arXiv:2304.07193 [cs.CV][21]Thao Nguyen.(26 Jul,2023).Visual Instruction Inversion: Image Editing via Visual Prompting.arXiv:2307.14331 [cs.CV][22]Pengfei Liu.(28 Jul 2021).Pre-train, Prompt, and Predict: A Systematic Survey of Prompting Methods in Natural Language Processing.arXiv:2107.13586 [cs.CL][23]Microsoft.( February 20,2023).ChatGPT for Robotics: Design Principles and Model Abilities. https://www.microsoft.com/en-us/research/group/autonomous-systems-group-robotics/articles/chatgpt-for-robotics/[24]Heewoo Jun, Alex Nichol.(3 May,2023).Shap-E: Generating Conditional 3D Implicit Functions. arXiv:2305.02463 [cs.CV]

附政策文件

生成式人工智能服务管理暂行办法

第一章 总 则

第一条 为了促进生成式人工智能健康发展和规范应用,维护国家安全和社会公共利益,保护公民、法人和其他组织的合法权益,根据《中华人民共和国网络安全法》、《中华人民共和国数据安全法》、《中华人民共和国个人信息保护法》、《中华人民共和国科学技术进步法》等法律、行政法规,制定本办法。

第二条 利用生成式人工智能技术向中华人民共和国境内公众提供生成文本、图片、音频、视频等内容的服务(以下称生成式人工智能服务),适用本办法。

国家对利用生成式人工智能服务从事新闻出版、影视制作、文艺创作等活动另有规定的,从其规定。

行业组织、企业、教育和科研机构、公共文化机构、有关专业机构等研发、应用生成式人工智能技术,未向境内公众提供生成式人工智能服务的,不适用本办法的规定。

第三条 国家坚持发展和安全并重、促进创新和依法治理相结合的原则,采取有效措施鼓励生成式人工智能创新发展,对生成式人工智能服务实行包容审慎和分类分级监管。

第四条 提供和使用生成式人工智能服务,应当遵守法律、行政法规,尊重社会公德和伦理道德,遵守以下规定:

(一)坚持社会主义核心价值观,不得生成煽动颠覆国家政权、推翻社会主义制度,危害国家安全和利益、损害国家形象,煽动分裂国家、破坏国家统一和社会稳定,宣扬恐怖主义、极端主义,宣扬民族仇恨、民族歧视,暴力、淫秽色情,以及虚假有害信息等法律、行政法规禁止的内容;

(二)在算法设计、训练数据选择、模型生成和优化、提供服务等过程中,采取有效措施防止产生民族、信仰、国别、地域、性别、年龄、职业、健康等歧视;

(三)尊重知识产权、商业道德,保守商业秘密,不得利用算法、数据、平台等优势,实施垄断和不正当竞争行为;

(四)尊重他人合法权益,不得危害他人身心健康,不得侵害他人肖像权、名誉权、荣誉权、隐私权和个人信息权益;

(五)基于服务类型特点,采取有效措施,提升生成式人工智能服务的透明度,提高生成内容的准确性和可靠性。

第二章 技术发展与治理

第五条 鼓励生成式人工智能技术在各行业、各领域的创新应用,生成积极健康、向上向善的优质内容,探索优化应用场景,构建应用生态体系。

支持行业组织、企业、教育和科研机构、公共文化机构、有关专业机构等在生成式人工智能技术创新、数据资源建设、转化应用、风险防范等方面开展协作。

第六条 鼓励生成式人工智能算法、框架、芯片及配套软件平台等基础技术的自主创新,平等互利开展国际交流与合作,参与生成式人工智能相关国际规则制定。

推动生成式人工智能基础设施和公共训练数据资源平台建设。促进算力资源协同共享,提升算力资源利用效能。推动公共数据分类分级有序开放,扩展高质量的公共训练数据资源。鼓励采用安全可信的芯片、软件、工具、算力和数据资源。

第七条 生成式人工智能服务提供者(以下称提供者)应当依法开展预训练、优化训练等训练数据处理活动,遵守以下规定:

(一)使用具有合法来源的数据和基础模型;

(二)涉及知识产权的,不得侵害他人依法享有的知识产权;

(三)涉及个人信息的,应当取得个人同意或者符合法律、行政法规规定的其他情形;

(四)采取有效措施提高训练数据质量,增强训练数据的真实性、准确性、客观性、多样性;

(五)《中华人民共和国网络安全法》、《中华人民共和国数据安全法》、《中华人民共和国个人信息保护法》等法律、行政法规的其他有关规定和有关主管部门的相关监管要求。

第八条 在生成式人工智能技术研发过程中进行数据标注的,提供者应当制定符合本办法要求的清晰、具体、可操作的标注规则;开展数据标注质量评估,抽样核验标注内容的准确性;对标注人员进行必要培训,提升尊法守法意识,监督指导标注人员规范开展标注工作。

第三章 服务规范

第九条 提供者应当依法承担网络信息内容生产者责任,履行网络信息安全义务。涉及个人信息的,依法承担个人信息处理者责任,履行个人信息保护义务。

提供者应当与注册其服务的生成式人工智能服务使用者(以下称使用者)签订服务协议,明确双方权利义务。

第十条 提供者应当明确并公开其服务的适用人群、场合、用途,指导使用者科学理性认识和依法使用生成式人工智能技术,采取有效措施防范未成年人用户过度依赖或者沉迷生成式人工智能服务。

第十一条 提供者对使用者的输入信息和使用记录应当依法履行保护义务,不得收集非必要个人信息,不得非法留存能够识别使用者身份的输入信息和使用记录,不得非法向他人提供使用者的输入信息和使用记录。

提供者应当依法及时受理和处理个人关于查阅、复制、更正、补充、删除其个人信息等的请求。

第十二条 提供者应当按照《互联网信息服务深度合成管理规定》对图片、视频等生成内容进行标识。

第十三条 提供者应当在其服务过程中,提供安全、稳定、持续的服务,保障用户正常使用。

第十四条 提供者发现违法内容的,应当及时采取停止生成、停止传输、消除等处置措施,采取模型优化训练等措施进行整改,并向有关主管部门报告。

提供者发现使用者利用生成式人工智能服务从事违法活动的,应当依法依约采取警示、限制功能、暂停或者终止向其提供服务等处置措施,保存有关记录,并向有关主管部门报告。

第十五条 提供者应当建立健全投诉、举报机制,设置便捷的投诉、举报入口,公布处理流程和反馈时限,及时受理、处理公众投诉举报并反馈处理结果。

第四章 监督检查和法律责任

第十六条 网信、发展改革、教育、科技、工业和信息化、公安、广播电视、新闻出版等部门,依据各自职责依法加强对生成式人工智能服务的管理。

国家有关主管部门针对生成式人工智能技术特点及其在有关行业和领域的服务应用,完善与创新发展相适应的科学监管方式,制定相应的分类分级监管规则或者指引。

第十七条 提供具有舆论属性或者社会动员能力的生成式人工智能服务的,应当按照国家有关规定开展安全评估,并按照《互联网信息服务算法推荐管理规定》履行算法备案和变更、注销备案手续。

第十八条 使用者发现生成式人工智能服务不符合法律、行政法规和本办法规定的,有权向有关主管部门投诉、举报。

第十九条 有关主管部门依据职责对生成式人工智能服务开展监督检查,提供者应当依法予以配合,按要求对训练数据来源、规模、类型、标注规则、算法机制机理等予以说明,并提供必要的技术、数据等支持和协助。

参与生成式人工智能服务安全评估和监督检查的相关机构和人员对在履行职责中知悉的国家秘密、商业秘密、个人隐私和个人信息应当依法予以保密,不得泄露或者非法向他人提供。

第二十条 对来源于中华人民共和国境外向境内提供生成式人工智能服务不符合法律、行政法规和本办法规定的,国家网信部门应当通知有关机构采取技术措施和其他必要措施予以处置。

第二十一条 提供者违反本办法规定的,由有关主管部门依照《中华人民共和国网络安全法》、《中华人民共和国数据安全法》、《中华人民共和国个人信息保护法》、《中华人民共和国科学技术进步法》等法律、行政法规的规定予以处罚;法律、行政法规没有规定的,由有关主管部门依据职责予以警告、通报批评,责令限期改正;拒不改正或者情节严重的,责令暂停提供相关服务。

构成违反治安管理行为的,依法给予治安管理处罚;构成犯罪的,依法追究刑事责任。

第五章 附 则

第二十二条 本办法下列用语的含义是:

(一)生成式人工智能技术,是指具有文本、图片、音频、视频等内容生成能力的模型及相关技术。

(二)生成式人工智能服务提供者,是指利用生成式人工智能技术提供生成式人工智能服务(包括通过提供可编程接口等方式提供生成式人工智能服务)的组织、个人。

(三)生成式人工智能服务使用者,是指使用生成式人工智能服务生成内容的组织、个人。

第二十三条 法律、行政法规规定提供生成式人工智能服务应当取得相关行政许可的,提供者应当依法取得许可。

外商投资生成式人工智能服务,应当符合外商投资相关法律、行政法规的规定。